AI如何切入crypto?针对crypto从业者的AIGC速成学习

作者:北辰

链茶馆上周四在外滩8号举办了主题为「从技术逻辑出发,临界点的AIGC如何切入crypto?」的闭门聚会。

不过严格来说不能称之为闭门聚会,因为嘉宾太多,都塞爆了走廊……

原本的计划是先由资深的AI和区块链技术专家以及元宇宙资深从业者做科普性质的介绍,然后在开放式讨论中,大家一起去探讨二者结合的可能性。

但由于AI是crypto行业之外的前沿领域,因此这场活动大家讨论得比较少,很大程度上是「针对crypto从业者的AI速成学习研讨班」。因为现场除了专家,大家很少输出观点,而是在不停提问……

不过从效果上来说,这场活动非常成功!

可以大言不惭地说,经过两三个小时高密度的交流,现场的crypto从业者对AI的认知超过了科技领域的平均水平(但不包括AI行业)。例如在36氪的这篇《ChatGPT大热硅谷,但热闹是他们的》文章中,就有不少所谓的内行人(尤其是投资人)说了外行话。

由于本场活动中的嘉宾观点过于犀利也过于技术流,这里删繁就简地整理部分适合公开发表的信息,但还是有必要隐去嘉宾个人信息。

(主持人片面的总结的预告:AI作为生产力工具已经突破了临界点,但是跟区块链的结合点似乎只有挖矿……)

AI技术专家

· 自监督学习让AI可以自己去迭代

在自然语言处理(NLP)领域,2018年以前的模型是以监督性学习的方式去训练,就是说所有喂给模型的数据都是人工标注的,成本非常高,而且速度也非常慢。这时候其实不是人工智能,而是人工弱智。大家都体验过机器人客服,聊天质量非常差,就是因为数据不够。

2018年以后,学术界提出了一种自监督学习的方法,可以让模型自己去训练。今天的ChatGPT本质上是GPT-3.5,未来OpenAI会正式推出GPT-4,而在此之前的GPT-1到GPT-3也都是基于自监督学习去训练的。

简单来说就是从文章里抽出词汇,让模型去猜测是什么词汇,然后在猜测的结果与正确答案之间进行损失函数的计算,如果有偏差就再去训练,这样它就可以自己去迭代了。经过海量数据的训练,模型就可以实现完形填空甚至阅读理解这种自然语言处理的基础任务。

OpenAI推出的从文本到图像的多模态模型DALL·E 2,也是去设定一些预训练的任务,让它自己去执行任务来自我迭代。如此惊艳的效果是人工标注的监督性学习不可能实现的。

· Transformer模型让AI可以并行大规模训练,强化学习让AI有更好的对话能力

除了自监督学习的方法,在NLP模型内部也有许多迭代,它们共同推动了今天的爆发。例如2017年学术界提出了能够实现并行大规模训练的Transformer(原始论文:《Attention Is All You Need》),后来将Transformer和自监督学习组合到一起,开发出了T-PTLM模型,GPT和BERT就是最早的T-PTLM。

· GPU推动了AI的爆发

另外,AI的发展也跟芯片的发展息息相关,特别是步入GPU时代以后,AI才有了井喷式的发展,以后的TPU还会进一步推动AI的爆发。

· AI在算力和数据的成本投入上依然非常高

但是现在AI依然存在一个问题,就是还是在堆算力和堆数据,投入成本非常高。即使是基于开源的大模型然后在子领域进行调优,也需要有该领域的海量数据和超大算力。

比如做图像生成的Stability AI,基于开源模型然后自己喂数据出来的效果非常好,但成本也超过了5000万美元,后来以10亿美元估值融资1亿美元,但它把开源算法给商用又牵涉到了法务问题。

所以创业公司即使是基于开源的AI模型去搞垂直应用,除了要与大公司在技术上竞争(其实很多大公司也是根据自己的业务场景去改进一些开源的模型),更重要的是在数据和算力上的竞争,因为定制化的模型需要重新训练数据,而这个成本非常高。

· AI在今天的发展远远达不到模拟人脑的水平,这其实有待于脑科学的突破

当然从更宏观的技术层面去看,AI在今天的发展其实还是在延续上世纪六七十年代的神经网络的模型,远远达不到模拟人脑的水平,因为人脑去学习根本就不需要那么多数据。所以未来如果要出现「强人工智能」,其实需要脑科学的重大突破,数学模型才会迭代,现有的数学模型的描述太简单了。

当然现在也有人在研究小样本学习(low-shot learning,LSL),但它也是基于预训练模型,需要先投入大量的数据和算力,而人类在学习中需要的数据量就远少于现在的模型所需要的海量数据。

· 图灵测试也该迭代了

现在的AI(包括ChatGPT)并不能真正理解问题,但是能够通过图灵测试,让你分辨不出是人还是机器,所以说图灵测试其实也该迭代了。

AI现在能做的只是一个赋能的工具,可以提高生产力,还达不到智能体的水平。

· ChatGPT可以马上替代套路化的工作

ChatGPT可以马上替代那些套路化的工作,比如按模板去起草法律文书、普通文案之类,以及中低端的程序员也会被替代,最后需要的是AI科学家和架构师。

· 多模态是AI未来一个非常大的方向

AI还有一个很大的方向叫多模态,把各种数据类型(文字、图片、音频、视频等)结合到一起来处理。

区块链技术专家

· 区块链技术目前不足以支撑AI的需求

AIGC和区块链的结合点比较少,因为目前区块链技术的发展水平不足以支撑AIGC的需求。

AI应用必然需要复杂的代码才能表达清楚,但区块链能够记录的信息本来就比较少,如果把智能合约拆分成许多个合约,就会导致Gas费很贵,并且逻辑上也有可能讲不清楚。

· 区块链只能做到记录AIGC应用的少量数据

区块链能为AIGC所能做的就是记账,但即便如此,也没有一条公链能够支撑,因为AIGC应用可能面对的是海量用户,所以最终只能把少量的数据记到区块链上。

· 大多数区块链标榜的亮点无非是嫁接了Web2的成熟技术

除非区块链技术未来能保持高速迭代,否则不仅很难跟AI结合,甚至区块链自身也会没有未来。

自从以太坊并行以后,大部分的区块链项目无非是在以太坊的基础上嫁接一些Web2的成熟技术,然后以此作为亮点来标榜,但区块链实际的演进速度其实慢于大家的预期。

· Solana和Dfinity是中心化的解决方案

例如Solana引入的全局时钟就是一个中心化的解决方案,而Dfinity索性去掉了全局状态,失去了区块链最基本的特性,跟云计算没有太大差别,而且还要再重新计费一次,成本必然更高,效率也必然更低。

· Aptos既没有区块也没有链,没有完整的设计思想

最近出来的Aptos甚至根本就不能称之为区块链,因为既没有区块也没有链。它没有区块链基本的结构——就是以上一个区块为指针去指向下一个区块,没有了全局化的状态数字,所以不同节点之间是一个混乱的状态,它的攻击成本远远小于比特币或者以太坊。但是它借鉴了Solana的全局时钟的概念。

总之Aptos把「不可能三角」中的去中心化和安全性这两个最重要的部分给去掉了,给人的感觉是一个半成品,而不是一个有完整的设计思想的公链项目。

元宇宙布道者

· 能用Web2做的事,就没必要用Web3重做一遍,如果非要做,那就是硬捞钱。

· AIGC为Web3带来了正外部性

从DeFi到GameFi都比较缺乏正外部性,大家都是冲着Earn来的,最后都是在系统内部不断循环,但是AIGC带来了正外部性。

· 我们自己做AIGC的应用,其实5万块钱的电脑就可以全本地了。

· 人类不能创造出一个推翻人类的人工智能,就像上帝能不能创造出自己拿不起来的石头。

· AIGC和区块链的结合点在GPU云算力

AIGC和区块链最有可能结合的地方可能是GPU云算力,类似于玩客云的逻辑。以前的矿池纯属空转,就是为了疯狂算哈希,完全是为生产关系去做赋能,AIGC的出现则提供了正外部性,可以把算力转化成生产力。

区块链技术专家反驳:

我要说一些反对意见。

算力挖矿在商业逻辑上不合理,因为做AI产品最稀缺的是数据,而不是算力,如果能有足够多的数据,那算力相对来说已经是低成本了。所以往往是大公司拿到海量数据,然后再自己设计一套硬件解决方案,这时候云算力其实没有竞争力。

另外,AI公司更需要的是被优化过的ASIC芯片,而不是GPU,因为成本太高了。

元宇宙布道者回应:

· 数据在5年前可能是问题,但在今天已经不成问题

9月份做文本转图像的Stable Diffusion开源了所有的模型库,然后AIGC市场被引爆了。Stable Diffusion的训练数据来源于他们资助的一家德国非营利组织LAION,而LAION的图片也是全网搜集的。

在法律上来讲,LAION作为非营利组织去共享图片让第三方浏览并不侵权,然后Stable Diffusion也做了一个声明,就是生成的图片的版权归用户,也就是说即使侵权被告,那也是用户的责任。这就实际上解决了AI公司的数据问题。

· AIGC领域会采用POS机制,这个完全适用于GPU

其次关于ASIC与GPU的问题,这就涉及到是POW机制还是POS机制的问题。

POW机制要疯狂地计算哈希算法,所以需要ASIC芯片,但给AI提供算力一定是基于POS机制,因为这些算力是能创造价值的,所以GPU完全可以被采用。

当然,GPU适合AIGC领域,但更专业的领域可能ASIC更合适。

题外话

现场讨论结束后,我问其中的一位一直在关注前沿科技的大厂投资人,比较看好投资AIGC赛道里哪种类型项目。

他说比较看好国内基于大模型的部署/加速技术(如百度文心、阿里M6这种千亿、万亿级别预训练的模型),以及明年估计会有一波基于大模型开放API的垂直应用类创业公司。国内公司的优势是会重新训练出一套中文版本的模型。

最后我也分享下作为创作者对AIGC的感想。

无论是创作分析型的还是灵感型的内容(即写研报还是写剧本),只要不停地给ChatGLP喂问题,然后把回答整理起来再润色下就行了。

创作者之前是基于搜索引擎去搜集信息,然后消化并输出内容,搜索引擎仅仅只是强化了信息检索的能力。现在是ChatGLP会搜集信息并初步消化,直接代替了创作者在基础性的工作上的思考,从而把重心会放在核心逻辑上,这是一种革命性的创作方式。

当然,创作者(从客服到文案到写程序)的市场需求不会变,但确实不需要太多的创作者了。因为一个人如果适应这种新的创作方式,就能完成一个几十上百人的团队才能完成的事。

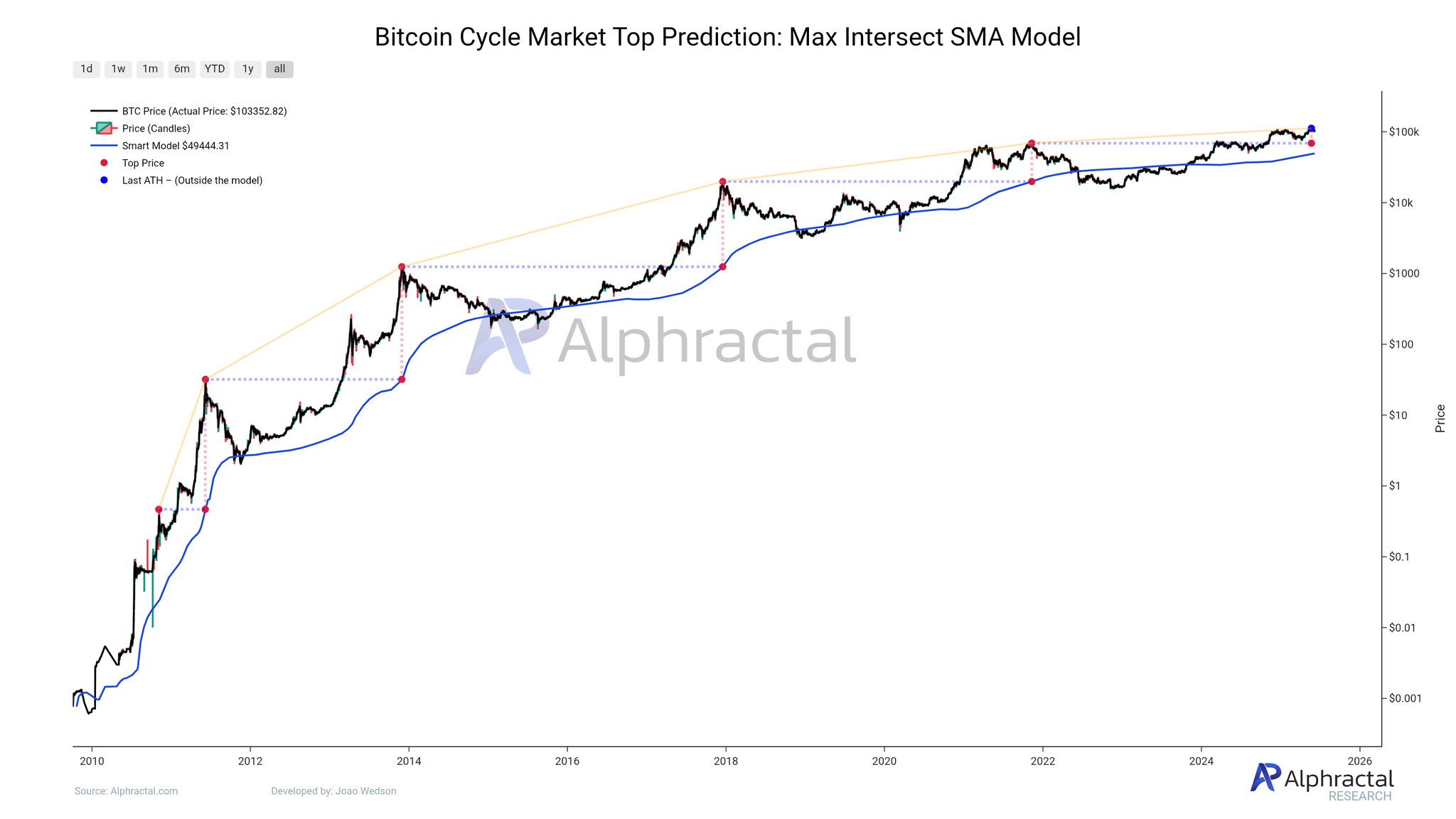

Bitcoin Historical Data Points To Imminent 62% Price Surge – Analyst

The Bitcoin market was recently subject to a significant price dip as a public feud between US Presi...

Terminus Partners with SKOR AI to Redefine Web3 Sector

The partnership focuses on establishing an interconnected and hyper-immersive ecosystem that merges ...

Crypto Analyst Says This Bitcoin Top Signal Hasn’t Gone Off Yet — What To Know

The story has been somewhat the same for the price of Bitcoin over the past week, drifting further f...