AIGC 困局与 Web3 破圈之道

作者: wheart.eth

图片来源:由 无界版图 AI 工具 生成。

最近一年,随着 AIGC(AI-Generated Content)技术的发展壮大,越来越多的人感受到了它的恐怖之处。AI 降低了创作门槛,使每个普通人都有机会展现自己的创造力,做出不输专业水平的作品。但是就在全民 AI 作图的进程中,艺术家好像与其站在了对立面。

以 Stable Diffusion 和 Midjourney 为代表的业内巨头经常受到艺术家们的集体抵制!究其原因无非两点:一是这些模型在未经允许的情况下使用艺术家的作品进行训练,做出的图片与艺术家风格极其类似,涉嫌侵权;二是某些传统艺术家认为,AI 只是对图片进行简单的拼接,不能算是艺术,它的滥用导致艺术市场震荡,出现“劣币驱逐良币”的现象。

综合来看,现在的 AIGC 市场就像一个怀揣着炸弹的巨人,外表看过去非常强大,但是内部有尚未解决的致命威胁,如果这个威胁不解除,行业发展终究受限,本文将详细聊聊出现这种情况的前因后果,并给出可能的解决方案。

最近越来越多的画家发现,Stable Diffusion 等 AIGC 模型使用的数据集里有自己的作品,并且这里不乏作者经过数十年的摸索形成的具有自己独特的风格画作,现在人们可以利用 AI 几秒钟生成相同风格的内容,这对艺术家来说显然是不公平的。

(左:AI生成图片,右:艺术家原图)

这引发了艺术家非常严重的担忧:他们自己的艺术正在被用来训练一个有朝一日可能会影响他们生计的计算机程序。更急迫的是,任何使用 Stable Diffusion 或 DALL-E 等系统生成图像的人都拥有对生成图像的版权和所有权(具体条款会有所不同)。一位插画师对此解释道:人们会使用 AI 生成图书封面、文章插图等内容,这将威胁他们的生计,毕竟站在购买者视角,当你可以免费在 1000 张图里挑来挑去时,为什么要付 1000 美元给创作者?况且这些都是在艺术家不知情的情况下进行的。

对于这个问题,Stability AI 创始人兼首席执行官 Emad Mostaque 表示,艺术只是 Stable Diffusion 背后的 LAION 训练数据的一小部分,艺术类图片占数据集的比例远低于 0.1%,并且只有在用户选择调用时才会创建。但是一些搜索工具收集的数据表明,在世艺术家的很多画作都在数据集之中,几千张画作的情况并不少见。

技术是原罪?

这个问题的出现不是偶然,而是必然,也是 AI 发展无法绕开的问题,要想详细了解缘由,我们或许可以通过 AIGC 技术原理与发展路径窥探一二。

AIGC是利用人工智能技术来生成内容。2021 年之前,AIGC生成的主要还是文字(代写文章),而新一代模型可以处理的格式内容包括:文字、声音、图像、视频、动作等等。AIGC 被认为是继专业生产内容(PGC,professional-generated content)、用户生产内容(UGC,User-generated content)之后的新型内容创作方式,可以在创意、表现力、迭代、传播、个性化等方面,充分发挥技术优势。2022 年 AIGC 发展速度惊人,年初还处于技艺生疏阶段,几个月之后就达到专业级别,足以以假乱真。

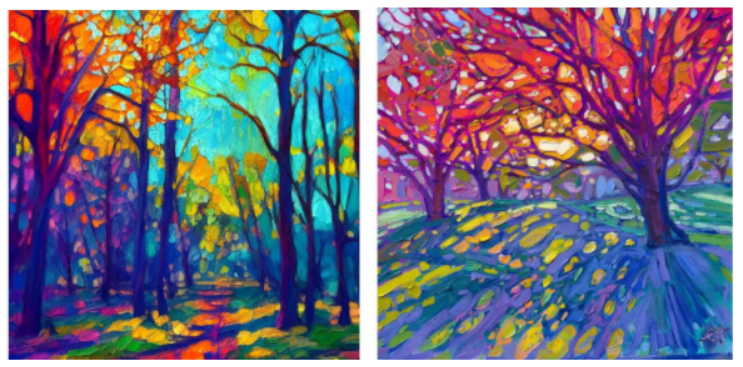

2014年提出的“对抗生成网络”GAN(Generative Adverserial Network)是前些年大热的深度学习模型,也可以算作AIGC的实用框架(去年年底还是主流的研究内容)。

GAN 的基本原理其实非常简单,这里以生成图片为例进行说明。假设我们有两个网络,G(Generator)和 D(Discriminator)。正如它的名字所暗示的那样,G 是一个生成图片的网络,它接收一个随机的噪声z,通过这个噪声生成图片,记做G(z)。D 是一个判别网络,判别一张图片是不是“真实的”。它的输入参数是 x,x 代表一张图片,输出 D(x) 代表x为真实图片的概率,如果为1,就代表100%是真实的图片,而输出为0,就代表不可能是真实的图片。在训练过程中,生成网络G的目标就是尽量生成真实的图片去欺骗判别网络 D。而 D 的目标就是尽量把G生成的图片和真实的图片分别开来。这样,G 和 D 构成了一个动态的“博弈过程”。最后博弈的结果是什么?在最理想的状态下,G 可以生成足以“以假乱真”的图片G(z)。对于D来说,它难以判定 G 生成的图片究竟是不是真实的,因此 D(G(z)) = 0.5。

这样我们的目的就达成了:我们得到了一个生成式的模型G,它可以用来生成图片。

但是 GAN 有三个不足:一是对输出结果的控制力较弱,容易产生随机图像;二是生成的图像分别率较低;三是由于 GAN 需要用判别器来判断生产的图像是否与其他图像属于同一类别,这就导致生成的图像是对现有作品的模仿,而非创新。因此依托 GAN 模型难以创作出新图像,也不能通过文字提示生成新图像。

GAN技术原理

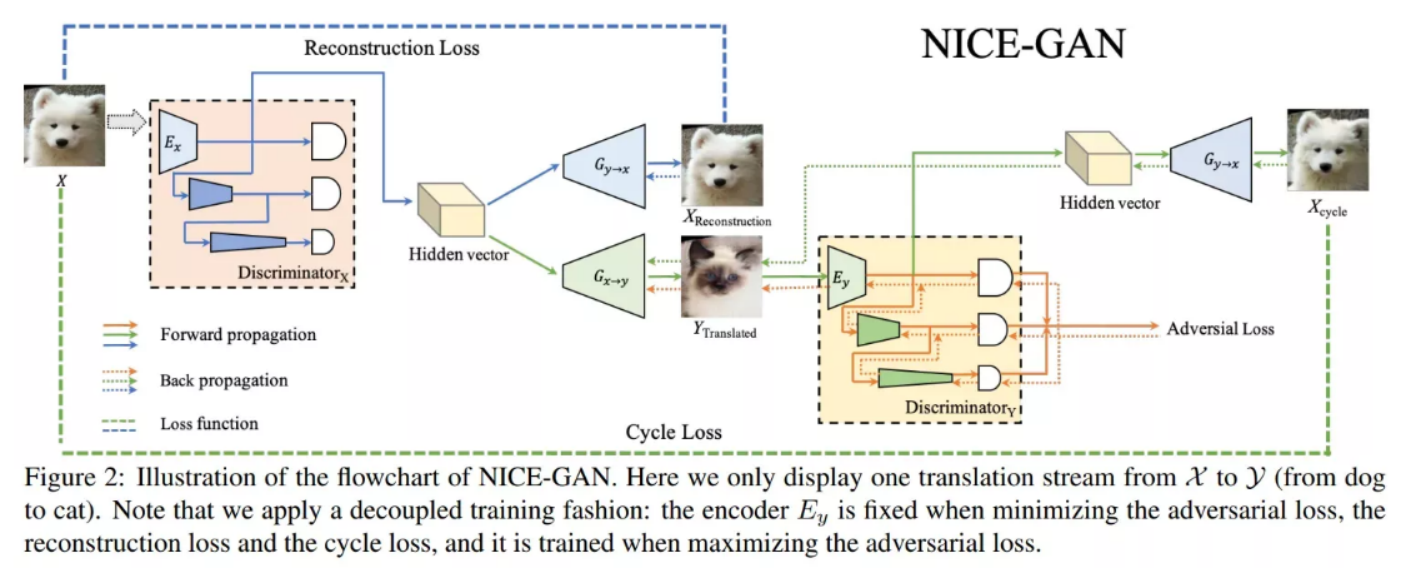

在 2021 年,OpenAI 团队将跨模态深度学习模型 CLIP(Contrastive Language-Image Pre-Training)进行开源。CLIP 模型能够将文字和图像进行关联,首先收集4亿未清洗的图像+文本pair的数据集,进行预训练以完成任务。用对比学习目标进行训练:分别对图像和文本编码(文本是一整句话),然后两两计算cosine相似度,再针对每个图片的一行或文本的一列进行分类,找出匹配的正例。每个图像都有32,768个文本候选,是SimCLR的两倍,负例个数的增多也是效果好的原因之一。在预测时也很简单,找一个图像分类的数据集,把label转为自然语言,比如“狗”可以转为“一张狗的照片”。再用预训练好的编码器对label和图像编码,再去计算相似度即可。

算法的总体过程可以总结为:输入图片,预测在32768个随机采样的文本片段集中,哪一个实际上与数据集配对。因为是文本描述不是具体的类别,所以可以在各种图像分类任务上进行zero-shot,其中Zero-Shot是一种迁移学习,描述一只斑马,可以用“马的轮廓+虎的皮毛+熊猫的黑白”,生成新的类别,普通的有监督分类器都可以将马、老虎、熊猫的图片正确分类,但遇到没有学习过的斑马的照片却无法分类,但是斑马却和已分类的图像有共同点,可以推理出这一新的类别。

所以思路就是:设置类别更细粒度的属性,以建立测试集与训练集之间的联系。比如将马的特征向量转换到语义空间,每一维代表一个类别的描述,【有尾巴1,马的轮廓1,有条纹0,黑白0】,熊猫就是【有尾巴0,马的轮廓0,有条纹1,黑白1】,这样定义一个斑马的向量,通过对比输入图片的向量与斑马向量之间的相似度就可以进行判别。

因此,CLIP 模型具备两个优势:一方面同时进行自然语言理解和计算机视觉分析,实现图像和文本匹配。另一方面为了有足够多标记好的“文本-图像”进行训练,CLIP 模型广泛利用互联网上的图片,这些图片一般都带有各种文本描述,成为CLIP 天然的训练样本。据统计,CLIP 模型搜集了网络上超过 40 亿个“文本-图像”训练数据,这为后续AIGC尤其是输入文本生成图像/视频应用的落地奠定了基础。

CLIP 技术原理图

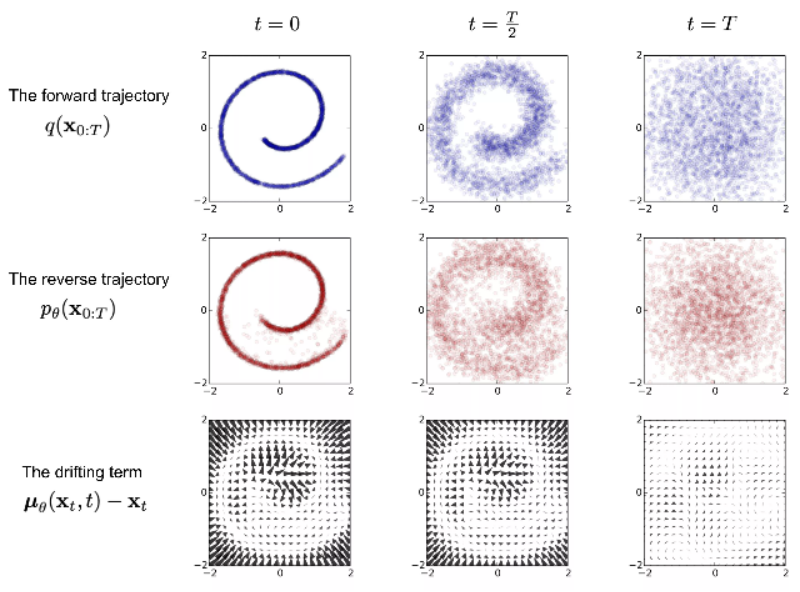

随后出现的 Diffusion 扩散模型,则真正让文本生成图像的 AIGC 应用为大众所熟知,也是2022 年下半年 Stable Diffusion 应用的重要技术内核。

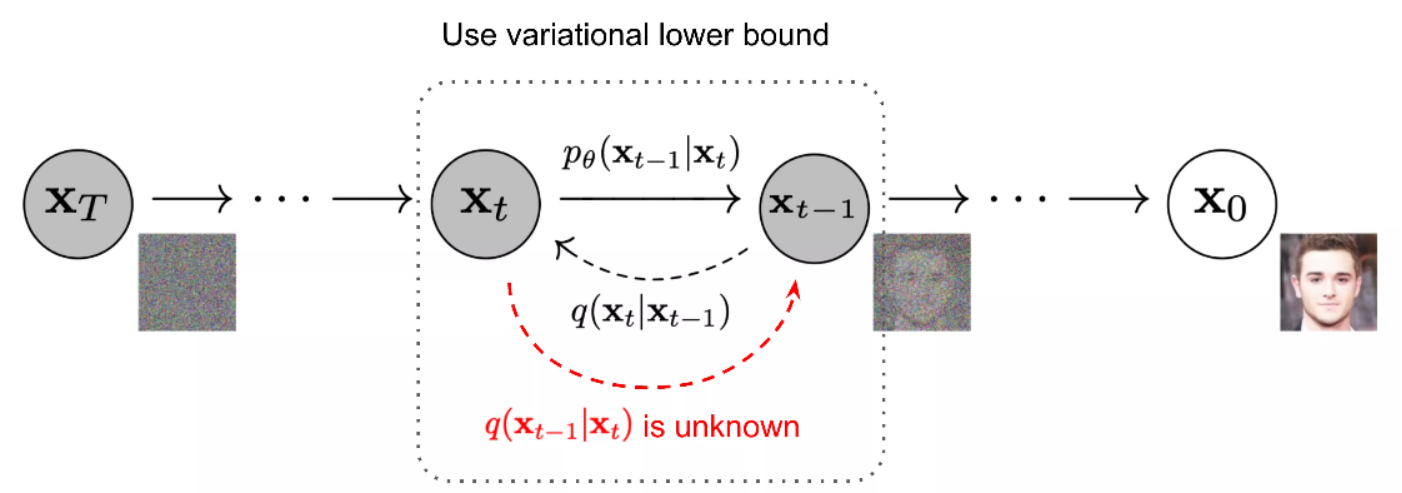

扩散模型的灵感来自于非平衡热力学。定义了一个扩散步骤的马尔可夫链(当前状态只与上一时刻的状态有关),慢慢地向真实数据中添加随机噪声(前向过程),然后学习反向扩散过程(逆扩散过程),从噪声中构建所需的数据样本。

Diffusion Models 技术原理图

前向过程是不断加噪的过程,加入的噪声随着时间步增加增多,根据马尔可夫定理,加噪后的这一时刻与前一时刻的相关性最高也与要加的噪音有关(是与上一时刻的影响大还是要加的噪音影响大,当前向时刻越往后,噪音影响的权重越来越大了,因为刚开始加一点噪声就有效果,之后要加噪声越来越多 )

逆向过程是从一个随机噪声开始,逐步还原成不带噪音的原始图片——去噪并实时生成数据。这里我们需要知道全部的数据集,所以需要学习一个神经网络模型(目前主流是U-net + attention结构)来近似这些条件概率,来运行反向扩散过程。

Diffusion Models 逆向过程

Diffusion 模型有两个特点:一方面,给图像增加高斯噪声,通过破坏训练数据来学习,然后找出如何逆转这种噪声过程以恢复原始图像。经过训练,该模型可以从随机输入中合成新的数据。另一方面,Stable Diffusion 把模型的计算空间从像素空间经过数学变换,降维到一个可能性空间的低维空间里,这一转化大幅降低了计算量和计算时间,使得模型训练效率大大提高。这算法模式的创新直接推动了AIGC技术的突破性进展。

AIGC 相关深度学习模型汇总

漏洞!

通过以上算法简介大家也可以明白,AIGC本质上就是机器学习,既然是这样,那就无法避免使用大量的数据集执行训练,在这之中确实存在损害图片版权者的利益。

虽然我们都知道这种情况的存在,但是仍然很难解决。

对于艺术家来说,虽然认为这些平台侵害了自己的权益,但是现在仍没有完善的法律规定此类侵权行为,甚至在某些法律条文中,这种行为是合法的。

一方面,AIGC难以被称为“作者”。著作权法一般规定,作者只能是自然人、法人或非法人组织,很显然AIGC不是被法律所认可的权利主体,因此不能成为著作权的主体。但AIGC应用对生成的图片版权问题持有不同观点,图片属于平台、完全开源还是生成者,目前尚未形成统一意见。

另一方面,AIGC产生的“作品”尚存争议。传统意义上的作品是指文学、艺术和科学领域内具有独创性并能以某种有形形式复制的智力成果。AIGC的作品具有较强的随机性和算法主导性,能够准确证明AIGC作品侵权的可能性较低。同时,AIGC是否具有独创性目前难以一概而论,个案差异较大。

即使现在把自己的作品从数据集中删除也无法阻止自己风格作品的生成,首先,AI 模型已经过训练,对应风格已经掌握。而且,由于 OpenAI 的 CLIP 模型(于训练 Stable Diffusion 以理解文字和图像之间的联系),用户仍然可以调用特定的艺术风格。

对于AI项目方来说,让数据集每张图片都得到授权是不现实的,如果此类法案通过,那么 AI 行业的发展将受到很大的阻碍,或许是灭顶之灾。所以我们需要一个折中的方案。

方案?

首先我们来分析一下AIGC行程的创作闭环:

在创意构思方面,AIGC构建了新的创意完善通路,传统的创作过程中消化、理解以及重复性工作将有望交由AIGC来完成,最终创意过程将变为“创意-AI-创作”的模式。

在创意实现方面,创作者和AIGC的关系类似于摄影师和照相机。摄影师构建拍摄思路并进行规划,对相机进行参数配置,但是不用了解相机的工作机制,一键生成高质量的内容。同样的,创作者构思并进行规划,对AI模型进行参数配置,不需要了解模型的原理,直接点击输出内容即可。创意和实现呈现出分离状态,实现过程变为一种可重复劳动,可以由AIGC来完成,并逐步将成本推向趋近于0。

所以这里有两个大主体:创作者和 AIGC。创意重要,创作同样也重要,AI做出的图片是创作者的“创意版权”,是AIGC或者说采用艺术家风格的“底层创意/创作版权”,两者都应该对生成内容享有权益,现在的情况就是少了艺术家的那份收益。

其实艺术家并不是不让 AI 学习他们的画作,只是也想在其中得到相应的收益,所以只要这份设计得到艺术家的承认,AIGC 的漏洞就得以修复。

创作者的成果是 AIGC 学习的对象,但创作者的创意才是关键,创意本身比AIGC生成的绘画更有价值,因此如何将创作者的“创意”进行量化,甚至定价,将有助于打造AIGC的商业模式。这其中“注意力机制”将成为 AIGC 潜在的量化载体。例如有机构专家提出,可以通过计算输入文本中关键词影响的绘画面积和强度,我们就可以量化各个关键词的贡献度。之后根据一次生成费用与艺术家贡献比例,就可以得到创作者生成的价值。最后在与平台按比例分成,就是创作者理论上因贡献创意产生的收益。

例如某AIGC平台一周内生成数十万张作品,涉及这位创作者关键词的作品有30000张,平均每张贡献度为0.3,每张AIGC绘画成本为0.5元,平台分成30%,那么这位创作者本周在该平台的收益为:30000*0.3*0.5*(1-30%)=3150元的收益,未来参与建立AI数据集将有望成为艺术家的新增收益。

但是以上设计也有缺陷,因为AI并不完美,并不是每张图片都有价值,所以这里优化方案可以是生成时不向艺术家付款,而有满意的内容想要下载时,才需要支付相应的费用。这也与传统的艺术创作领域流程相似,甲方下单,乙方提供满意的作品时,甲方支付所有款项。

为了让流程更加合规,更完美的做法是首先向全球艺术家公开风格库,每个艺术家都可以选择是否将自己的作品内容加入训练集图库中,如果加入则可以在其他用户创作对应风格时获得相应收益,这也是在另一方面为艺术家寻求新的收益途径。在市场上“侵权”行为如此多的背景下,此“正版授权”图库定会受到艺术家群体的支持,这种模式才更类似于正向循环,也是更良性的模式。

Web3?

Web3 一直在强调“创作者经济”,这与 AIGC 想要解决的问题不谋而合,利用区块链技术,完全可以打造一个围绕 AIGC 的生态网络。

创作者通过 AICG 的赋能,加上 Web3 模式下的经济模型,可以将自己的创意和影响力进行指数级的放大。也让更多的人能实现从消费到参与、从用户到所有者的转变。同时艺术家可以得到他赢得的收益份额,达到一个双赢局面。

其实 Web3+AI 并不是一件新鲜事,生成式艺术 NFT 领军者 Art Blocks 就是一个成功的应用案例。(虽然算法不同,但是仍旧是异曲同工。)

Art Blocks是一个生成随机艺术品的平台。它是由 Erick Snowfro 在 2020 年推出,是一个专注于可编程、生成性内容的平台,其生成的内容在以太坊区块链上是不可改变的。那么「随机艺术品」是如何随机的呢?这个随机过程是受一串数字控制的,这串数字存储在以太坊链上的一个非同质化代币(NFT)上。之后这个代币所存储的数字串控制你所购买艺术品的一系列属性,最终生成属于你的独一无二的艺术品。

如果你是一个买家,比较看好某个艺术家的风格,然后支付后开始铸造,算法生成随机的同风格的艺术品就会被发送到你的账户中,以代币的形式存在,最终的作品可能是静态图像、3D 模型或交互式的艺术品。每个输出都是不同的,并且在平台上创建的内容类型具有无限种可能性,但每个项目可铸造的艺术品的数量是一定的,也就是说一旦铸造满了,这个项目就不会有新的作品生成了。

对于创作者:他们需要预先在 Art Blocks 上调整和部署好自己的生成艺术脚本,并确保它的输出结果与输入的哈希值有关。这个脚本会通过 Art Blocks 存储在以太坊链上。

对于收藏者:当收藏者铸造某一系列的作品(你可以理解为点击购买按键时),他们实质上获得了一个随机的哈希值,然后脚本执行,一副对应这个哈希值的生成艺术作品当场被创作出来。

这种模式让收藏者也参与了生成艺术的创作。

这副作品的内容,实际上是由原艺术家的风格、生成算法和你的铸造时机三者决定。工具、创作者和买家联合完成了这样的作品,这种新的 NFT 创作模式让这幅艺术品拥有了更多的纪念价值,留下了当下最新技术的印记。

和购买主流的 NFT 头像项目不同,在 Art Blocks 上购买 NFT 更像是在直接支持一位艺术家——这些艺术家往往是实名的,有大量的历史作品,并且 Art Blocks 会对他们进行作品相关的深度采访。Art Blocks 上初次出售的NFT,艺术家可以获得 90% 的收入,剩下的 10% 分给 Art Blocks。

所以大家可以发现,Art Blocks 简直是给 AIGC 开辟了一条“康庄大道”,当然这条路并不完能粘贴复制,但是在细节方面对其修改完全可以成为 AIGC+Web3 的商业闭环!而且现在也已经有项目在做类似的事情。

正是因为有那么多先行者探路,我们有理由相信 AIGC 将会走的越来越远,现在的缺陷也将慢慢修补完善。

Bitcoin Looms Under $100k : A Bullish Momentum Is Coming

The post Bitcoin Looms Under $100k : A Bullish Momentum Is Coming appeared first on Coinpedia Fintec...

SHIB and DOGE: Which Meme Coin Will Dominate the Market in 2025?

The post SHIB and DOGE: Which Meme Coin Will Dominate the Market in 2025? appeared first on Coinpedi...

Hilbert Group Blends Liberty AI With Core Services to Lead in Asset Management

The post Hilbert Group Blends Liberty AI With Core Services to Lead in Asset Management appeared fir...