不做 ChatGPT killer,Meta 的大型语言模型 LLaMA 或派上更大用场

作者: Khushboo Gupta

编译:DeFi 之道

图片来源:由 Maze AI 生成

在过去几年中,大型语言模型(LLMs)在科技行业掀起了一场风暴。这些在海量数据上训练出来的语言模型可以完成各种任务,从总结文本和写诗这样的基本任务到生成人工智能(AI)艺术提示词甚至预测蛋白质结构这样更具挑战性的任务。

OpenAI 的 ChatGPT 是目前这类 LLM 最大和最知名的例子之一。使用生成性预训练转化器(Generative Pre-trained Transformer 3,GPT-3)的 ChatGPT 是一个基于对话的 AI 聊天界面,可以与人交谈,编写代码,回答问题,甚至解决具有挑战性的数学方程式。即使是其他科技巨头,如谷歌和微软,在发布他们的语言模型(如 BARD 和 Bing)时也还没有激起任何水花。

学术界普遍认为,在训练包含近 10 亿个参数的 LLM 时,增加更多的参数可以提高性能。最近的研究表明,在特定的训练计算预算下,相较于最大的模型,基于更多的数据训练的小模型会产生最好的性能。推理预算是另一个关键参数,对于获得理想的性能程度至关重要。尽管训练一个大的模型以达到一定的性能水平可能会更便宜,但训练时间较长的小模型最终在推理方面所需的成本更低。在某些情况下,理想的模型不是训练最快的模型,而是推理最快的模型。

为了在竞争激烈的生成式 AI 模型竞赛中崭露头角,Facebook 的母公司 Meta 推出了其 AI 语言模型系列 LLaMA。这项工作旨在开发几种在不同推理预算下表现最佳的语言模型,激励 AI 社区开展研究,创造更负责任的语言模型。

在以前,接触到这种语言模型是昂贵和有限制的,因为它们经常需要服务器来运行。但有了 LLaMA,Meta 的目标正是为研究人员解决这个问题。Meta 表示,LLaMA 仅在公开可用的数据上进行训练,其性能超过了目前已经投入使用的更大的 AI 模型,包括 OpenAI 的老式 GPT-3 模型。在发布 LLaMA 上,Meta 对外展示了一个事实:不借助于专有的和不可获取的数据集就能训练最先进的模型。

Meta 已经开源了 LLaMA,希望这些模型能够让更多人用上并能够研究 LLM,因为它们可以在单个 GPU 上运行。这将使研究人员能够更彻底地理解 LLMs,并减少其他已知的问题,包括偏见、恶意信息和传播错误信息的可能。有关这个语言模型集合的另一个有趣的方面是,与 ChatGPT 和 Bing 等其他语言模型相比,LLaMA 是专门用于研究目的的,并在 "非商业许可" 下分发。目前,各种学术研究人员、政府、大学和其他学术机构都可以访问。

LLaMA 可以像其他 AI 驱动的聊天机器人一样,从文本输入提示词中产生类似人类的对话。有四种不同的模型,参数范围从 70 亿到 650 亿。与 OpenAI 早期的 GPT-3 模型相比,它几乎小了十倍。只有来自各个领域的、已经被用来训练其他 LLM 的公开可访问数据被用来训练这一系列基础模型。这使得这些模型更容易被开源。English CCNet、C4、GitHub、Wikipedia、Books、ArXiv 和 Stack Exchange 是用来训练 LLaMA 的一些数据源。Transformer 设计是 LLaMA 的基础,在过去几年中取得了进一步的进步。Meta 的研究人员使用标准 Transformer 在大量文本数据上训练大型 Transformer。

在最小的模型,即 LLaMA-7 B 的训练中使用了一万亿个 token(标注)。另一方面,像 LLaMA-33 B 和 LLaMA-65 B 这样具有较大参数的模型在 1.4 万亿个 token 上进行了训练。研究人员使用各种基准评估了他们的一系列基础模型,包括 BoolQ、WinoGrande、OpenBookQA、NaturalQuestions、RealToxicityPrompts、WinoGender 等。研究人员的两个最重要的发现是,LLaMA-13 B 模型,即第二小的版本,在大多数基准上都优于老的 GPT-3 模型,而且 LLaMA-65 B 模型与目前一些最好的模型相比具备竞争力,包括 DeepMind 的 Chinchilla-70 B 和谷歌的 PaLM-540 B 模型。

简而言之,Meta 为希望推进 LLM 研究并提高其鲁棒性的研究人员发布了一系列新颖的、最先进的 AI LLMs,名为 LLaMA。研究人员发现,在未来工作时,对这些模型进行指令微调会带来积极的结果。研究人员将对此进行进一步调查。为了提高性能,Meta 还寻求部署更大的模型,这些模型是在更大量的语料上训练出来的。

XRP Price Exhibiting Remarkable Strength—Could Hit $4 If This Trade Plays Out Well

The post XRP Price Exhibiting Remarkable Strength—Could Hit $4 If This Trade Plays Out Well appeared...

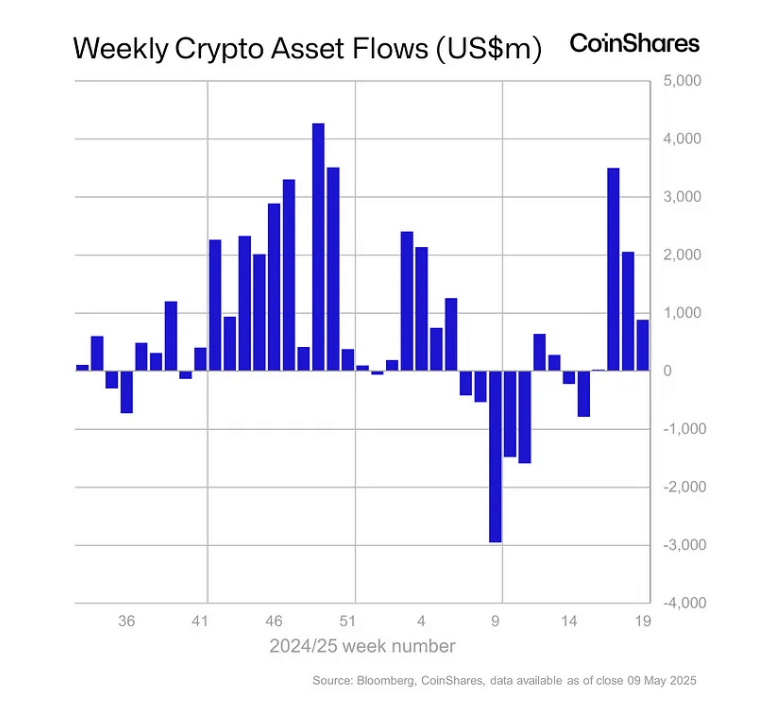

Bitcoin Reclaims Center Stage With $880 Million In Inflows

Last week saw another batch of new money flowing into crypto funds. As reported by CoinShares, inves...

Coinbase Rejects Bitcoin Hoarding, Rides Caution to S&P 500

While Coinbase prepares to join the S&P 500, executives reveal they once rejected the high-risk Bitc...