撰文:imToken

2025 年底,以太坊社区相对平静地迎来了 Fusaka 升级的收官。

回望过去一年,虽然关于底层技术升级的探讨已逐步淡出市场的聚光灯,但相信很多链上用户已经切身感受到一个显著变化:以太坊 L2 越来越便宜了。

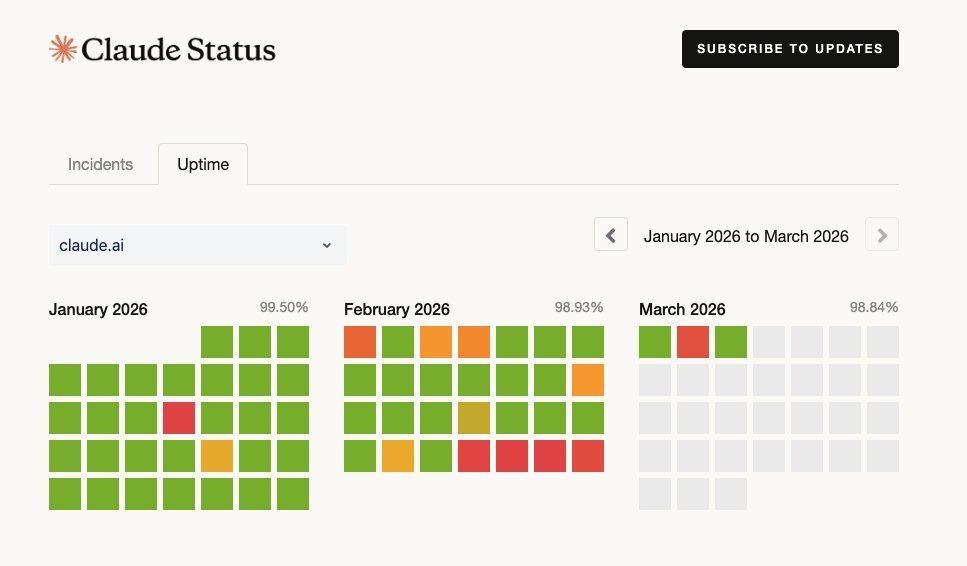

现在的链上交互,无论是转账还是复杂的 DeFi 操作,Gas 费往往只需要几美分甚至可以忽略不计,这背后,Dencun 升级和 Blob 机制固然功不可没,与此同时,随着 Fusaka 升级中核心特性 PeerDAS(Peer Data Availability Sampling,点对点的数据可用性抽样验证) 的正式激活,以太坊也正在彻底告别「全量下载」的数据验证时代。

可以说, 真正决定以太坊能否长期、可持续地承载大规模应用的,不只是 Blob 本身,而更在于 PeerDAS 所代表的下一步。

一、什么是 PeerDAS?

要理解 PeerDAS 的革命性意义,我们不能空谈概念,必须先回溯以太坊扩容路上的一个关键节点,即 2024 年 3 月的 Dencun 升级。

彼时 EIP-4844 通过引入携带 Blob 的交易模型(将大量交易数据嵌入 blob 中),使得 L2 们可以不再依赖昂贵的 calldata 存储机制,转而使用临时的 Blob 存储。

这一改动直接 让 Rollup 的成本降低至原先的数十分之一,保证 L2 平台可以提供更便宜、更快速的交易,而不会影响基于以太坊的安全性和去中心化程度, 也让我们广大用户尝到了「低 Gas 费时代」的甜头。

不过,虽然 Blob 很好用,但以太坊主网每个区块能承载的 Blob 数量是有硬上限的(通常是 3-6 个),原因非常现实,即物理带宽和硬盘是有限的。

而在传统的验证模式下,网络中的每一个验证者(Validator),无论是由专业机构运营的服务器,还是散户家里的普通电脑,仍然必须下载并传播完整的 Blob 数据,才能确认数据有效。

这就带来了一个两难的困境:

- 如果增加 Blob 数量(为了扩容):数据量激增,家庭节点的带宽会被跑满、硬盘会被塞爆,导致他们被迫下线,那网络将迅速中心化,最终变成只有大机房才能运行的巨头链;

- 如果限制 Blob 数量(为了去中心化):L2 的吞吐量就被锁死,无法应对未来爆发式增长的需求。

说白了,Blob 只是迈出了第一步,解决了数据「存哪里」的问题。当数据较少时,一切都没问题,但如果未来 Rollup 数量持续增加,每个 Rollup 都在高频提交数据,Blob 容量不断扩大,那么节点的带宽与存储压力就会成为新的中心化风险。

如果继续沿用传统的全量下载模式,解决不了带宽压力,以太坊的扩容之路将会在物理带宽的墙壁前撞得头破血流,而 PeerDAS,正是解开这道死结的钥匙。

如果用一句话来概括,PeerDAS 本质上是一种全新的数据验证架构,它打破了验证必须全量下载的铁律, 允许 Blob 的扩展超越当前的物理吞吐量水平(例如从 6 个 Blob/ 块跃升至 48 个甚至更多)。

二、Blob 解决「放哪」,PeerDAS 解决「咋存」

正如上文所言, Blob 迈出了扩容的第一步,解决了数据「存哪里」的问题(从昂贵的 Calldata 搬到了临时的 Blob 空间),那么 PeerDAS 要解决的就是「怎么更高效地存」的问题。

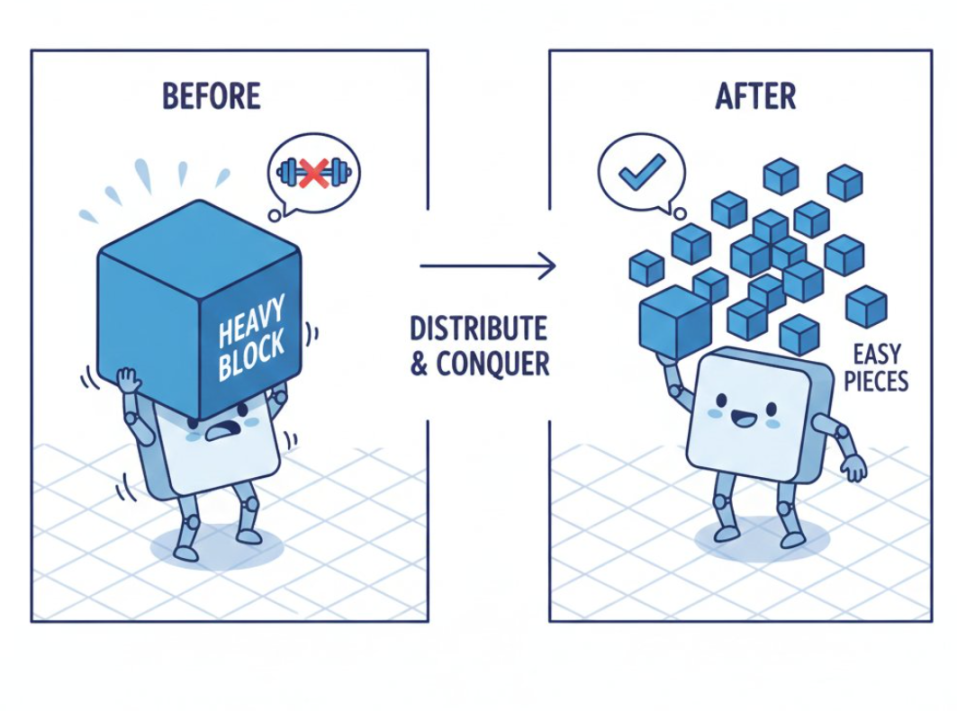

它要解决的核心问题是如何在数据量指数级膨胀的同时,不压垮节点的物理带宽?思路也很直接,即基于概率与分布式协作,「不需要每个人都存全量数据,也能高概率确认这些数据是真的存在的」。

这从 PeerDAS 的全称「点对点的数据可用性抽样验证」其实就可以看出端倪。

这个概念听起来晦涩,但我们可以用一个通俗的比喻来理解这种范式转移,譬如过去的全量验证,就好比图书馆进了一本几千页的《大英百科全书》(Blob 数据),为了防止丢失,要求每一个管理员(节点)都必须人手复印一本完整的书,作为备份。

那就意味着,只有有钱有闲(带宽 / 硬盘大)的人才能当管理员,尤其是这本《大英百科全书》(Blob 数据)还会不断膨胀,内容越来越多,那长此以往,普通人被淘汰,去中心化荡然无存。

而现在基于 PeerDAS 抽样,引入了纠删码(Erasure Coding)等技术,等于允许将这本书撕成无数个碎片,并进行数学编码扩展,每个管理员不再需要持有整本书,只需要随机抽取几页保存在手里。

即便进行验证时,也不需要任何人出示整本书,理论上只要全网凑齐任意 50% 的碎片(无论大家手里持有的是第 10 页还是第 100 页),我们就能通过数学算法,以 100% 的确定性瞬间还原出整本书的全貌。

这也是 PeerDAS 的魔力—— 把下载数据的重担,从单个节点身上卸下来,分散到了全网成千上万个节点组成的协作网络中。

来源:@Maaztwts

来源:@Maaztwts

仅从直观的数据维度看, 在 Fusaka 升级之前,Blob 的数量被死死卡在个位数(3-6 个)。而 PeerDAS 的落地,直接将这一上限撕开,允许 Blob 目标从 6 个跃升至 48 个甚至更多。

当用户在 Arbitrum 或 Optimism 上发起一笔交易,数据被打包传回主网时,不再需要全网广播完整数据包,这使得以太坊实现了扩容不再线性增加节点成本的跃迁。

客观而言,Blob + PeerDAS 才是完整的 DA(数据可用性)方案,从路线图角度看,这也是以太坊从 Proto-Danksharding 走向完整 Danksharding 的关键过渡。

三、后 Fusaka 时代的链上新常态

众所周知,前两年 Celestia 等第三方模块化 DA 层,一度因为以太坊主网贵而获得了巨大的市场空间,它们的叙事逻辑建立在一个前提之上,即以太坊原生的数据存储很贵。

那随着 Blob 及最新的 PeerDAS,现在的以太坊变得既便宜又极其安全 :L2 向 L1 发布数据的成本砍掉了一大半,此外以太坊又拥有全网最庞大的验证者集,安全性更远超第三方链。

客观而言,这对像 Celestia 等第三方 DA 方案来说,堪称降维打击,标志着以太坊正在重新夺回数据可用性的主权,极大地挤压他们的生存空间。

你可能会问,这些听起来都很底层,和我用钱包、转账、DeFi 有什么关系?

关系其实非常直接。如果 PeerDAS 能顺利落地,意味着 L2 的数据成本可以长期保持低位,Rollup 不会因为 DA 成本反弹而被迫涨费,链上应用也可以放心设计高频交互,钱包与 DApp 不必在「功能 vs 成本」之间反复妥协....

换句话说, 我们今天能用上便宜的 L2,是 Blob 的功劳,如果未来还能一直用得起,就离不开 PeerDAS 的默默贡献。

这也是为什么在以太坊的扩容路线图中,PeerDAS 虽然低调,却始终被视为不可绕过的一站,本质上,这也是笔者眼中技术最好的形态——「受益而不觉,失之则难存」,让你感觉不到它的存在。

说到底,PeerDAS 证明了区块链可以通过精妙的数学设计(如数据采样等),在不过度牺牲去中心化愿景的同时,承载 Web2 级别的海量数据。

至此,以太坊的数据高速公路已彻底铺好,接下来在这条路上跑什么车,就是应用层该回答的问题了。

让我们拭目以待。