原文作者:Anastasia Matveeva- Gonka 协议联合创始人

目录

- 真正的“去中心化”

- 区块链与推理验证

- 实际运作方式

- 安全与性能的权衡

- 优化空间

当我们开始构建 Gonka 时,我们有一个愿景:如果任何人都能运行 AI 推理并因此获得报酬,会怎么样?如果我们可以利用所有未被使用的计算能力,而不是依赖昂贵的中心化服务商,会怎么样?

目前的 AI 格局由少数几家大型云服务商主导:AWS、Azure 和 Google Cloud 控制着全球大部分 AI 基础设施。这种中心化带来了一些我们许多人都亲身经历过的严重问题。少数公司控制 AI 基础设施意味着他们可以任意定价、审查不喜欢的应用,并造成单点故障。当 OpenAI 的 API 宕机时,成千上万的应用随之崩溃。当 AWS 出现中断时,半个互联网都停止了运转。

即使是“高效”的前沿领域也不便宜。Anthropic 曾表示训练 Claude 3.5 Sonnet 花费了“几千万美元”,而 Claude Sonnet 4 现已普遍可用,Anthropic 尚未公布其训练成本。其首席执行官 Dario Amodei 此前预测,前沿模型的训练成本将接近 10 亿美元,而下一波模型将达到数十亿美元。在这些模型上运行推理同样不便宜。对于一个中等活跃度的应用来说,单次 LLM 推理每天可能花费数百到数千美元。

与此同时,世界上有大量的计算能力被闲置(或被以无意义的方式使用)。想想那些为了解决毫无价值的哈希谜题而消耗电力的比特币矿工,或是运行容量未满的数据中心。如果这些计算能力能够用于真正有价值的事情,比如 AI 推理,会怎么样?

去中心化方法可以将计算能力汇集起来,降低资本门槛,减少单一供应商瓶颈。我们不再依赖少数几家大公司,而是可以创建一个网络,让任何拥有 GPU 的人都能参与其中,并通过运行 AI 推理获得报酬。

我们知道,构建一个可行的去中心化解决方案将非常复杂。从共识机制到训练协议再到资源分配,有无数个需要协调的部分。今天我想重点讨论其中一个方面: 运行特定 LLM 的推理 。这究竟有多难?

什么是真正的“去中心化”

当我们谈论 去中心化 的 AI 推理时,我们指的是一个非常具体的东西。它不仅仅是让 AI 模型在多台服务器上运行,而是要构建一个系统,让任何人都可以加入,贡献算力,并因诚实工作而获得奖励。

关键要求是系统必须是 无信任 的。这意味着你不必信任任何个人或公司来正确运行系统。如果你要让互联网上的陌生人来运行你的 AI 模型,你需要有密码学上的保证,来确保他们确实在做他们声称在做的事情(至少要有足够高的概率)。

这个无信任的要求带来了一些有趣的含义。首先,这意味着系统需要 可验证 :你需要能够证明,用于生成给定输出的是同一个模型和相同的参数。这对于需要验证其所获得的 AI 响应是否合法的智能合约尤为重要。

但这存在一个挑战:你添加的验证越多,整个系统就越慢,因为网络的算力被消耗在验证上。如果你完全信任所有人,就不需要验证推理,性能几乎和中心化服务商一样。但如果你不信任任何人,总要验证一切,系统就会变得非常慢,无法与中心化解决方案竞争。

这就是我们一直在努力解决的核心矛盾:在 安全与性能 的权衡中找到正确的平衡点。

区块链与推理验证

那么,如何实际验证某人运行了正确的模型和参数?区块链成为了一个显而易见的选择——尽管它也有自己的挑战,但它仍然是我们所知的创建不可篡改事件记录的最可靠方式。

基本思想相当直接。当有人运行推理时,他们需要提供使用正确模型的证明。这个证明被记录在区块链上,创建了一个永久的、防篡改的记录,任何人都可以验证。

问题是区块链很慢。真的非常慢。如果我们试图将推理的每一步都记录在链上,巨大的数据量会很快使网络瘫痪。这正是我们在设计 Gonka 网络时,驱动了许多决策的限制条件。

在设计网络和思考分布式计算时,有多种策略可供选择。你可以将模型分片到多个节点上,还是让完整的模型驻留在一个节点中?主要的限制来自网络带宽和区块链速度。为了使我们的解决方案可行,我们选择了让一个完整模型适配一个节点,尽管这在未来可能会改变。这确实对加入网络增加了最低要求,因为每个节点需要足够的计算能力和内存来运行整个模型。尽管如此,一个模型仍然可以在属于同一节点的多个 GPU 之间进行分片,这给了我们在单节点限制内一些灵活性。我们使用 vLLM,它允许自定义张量和流水线并行参数以实现最佳性能。

实际运作方式

因此,我们达成一致:每个节点托管一个完整的模型并运行完整的推理,从而避免了在实际计算过程中需要跨多台机器进行协调。区块链仅用于记录。我们只记录用于推理验证的交易和工件(artifacts)。实际计算发生在链下。

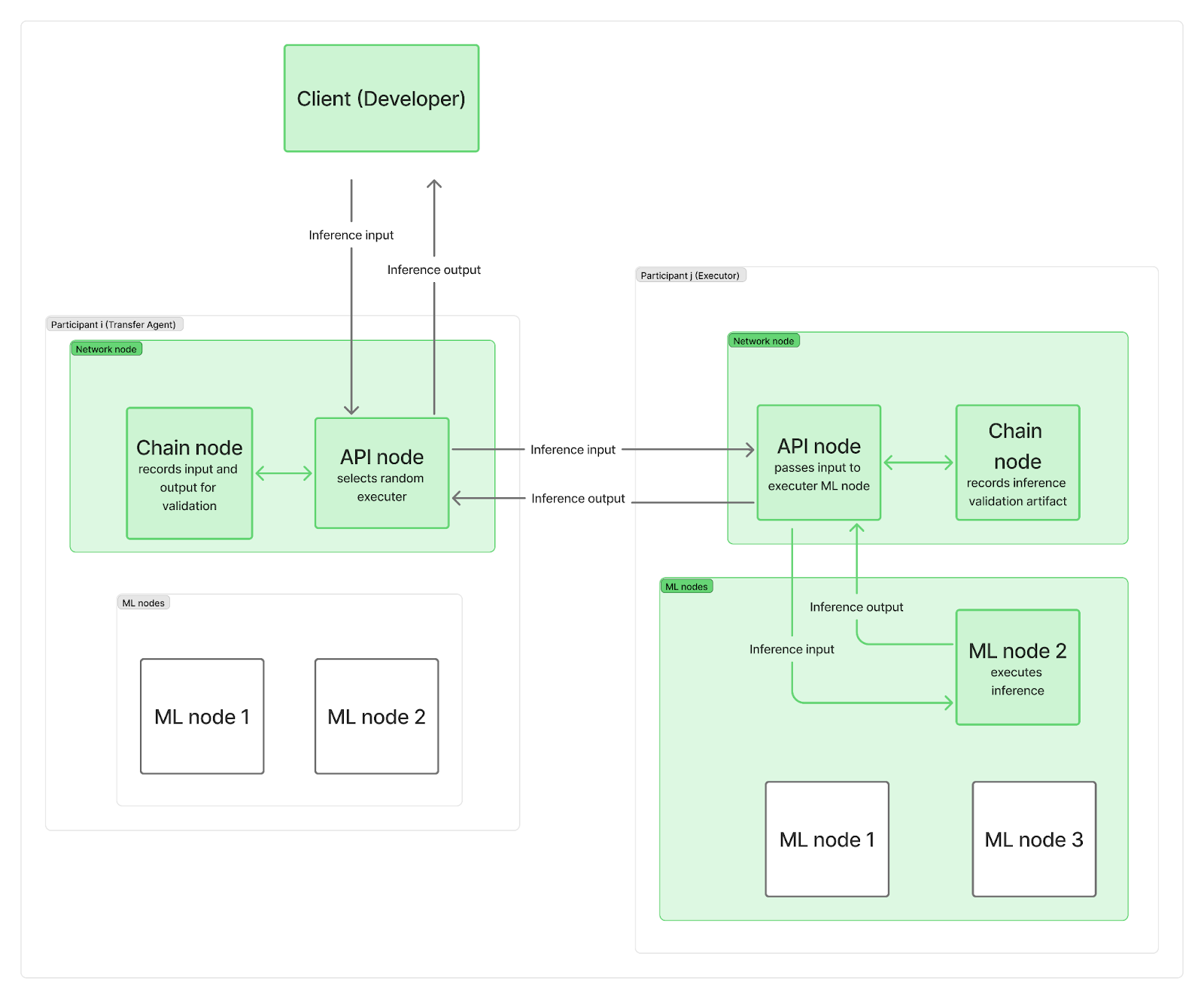

我们希望系统是去中心化的,没有任何单一中心点来指挥推理请求到网络节点。实际上,每个参与者至少部署两个节点:一个网络节点和一个或多个推理(ML)节点。网络节点负责通信(包括一个连接到区块链的链节点和一个管理用户请求的 API 节点),而你的 ML 节点则执行 LLM 推理。

当一个推理请求到达网络时,它会到达其中一个 API 节点(充当“传输代理”),该代理会随机选择一个“执行者”(来自不同参与者的 ML 节点)。为了节省时间并将区块链记录与实际 LLM 计算并行化,传输代理(TA)首先将输入请求发送给执行者,并在执行者的 ML 节点正在运行推理时,将输入记录在链上。计算完成后,执行者将输出发送给 TA 的 API 节点,同时其自身的链节点会将某个验证工件记录在链上。TA 的 API 节点会将输出传回给客户端,并同样记录在链上。当然,这些记录仍然会造成整体网络带宽限制。

正如你所看到的,区块链记录既没有拖慢推理计算的开始,也没有拖慢最终结果返回给客户端的时间。推理是否诚实地完成的验证是在之后,与其他推理并行进行的。如果执行者被发现作弊,他们将失去整个纪元的奖励,而客户端会收到通知并获得退款。

最后的问题是:工件中包含了什么,以及我们多久验证一次推理?

安全与性能的权衡

根本的挑战是,安全与性能是相互矛盾的。

如果你想要最大的安全性,你需要验证一切。但这既慢又昂贵。如果你想要最大的性能,你就需要信任所有人。但这有风险,并会让你面临各种攻击。

经过一番尝试、错误和参数调整后,我们找到了一种试图平衡这两种考量的方法。我们必须仔细调整验证的量、验证的时间以及如何使验证过程尽可能高效。验证太多,系统将变得无法使用;验证太少,系统则变得不安全。

保持系统轻量化至关重要。我们必须通过存储 前 k 个 下一个 token 的概率来保持工件的轻量性。我们用它们来衡量某个输出是否确实是由声称的模型和参数生成的可能性,并以足够高的置信度捕获任何篡改行为,例如使用更小的模型或量化模型。我们将在另一篇文章中更详细地介绍推理验证程序的具体实现。

同时,如何决定验证哪些推理、不验证哪些?我们选择了基于声誉的方法。当一个新参与者加入网络时,他们的声誉为 0,他们 100% 的推理都将至少被一个参与者验证 。如果发现问题,最终会使用共识机制来确定是否通过你的推理,或者降低你的声誉,并可能将你踢出网络。随着你的声誉增长,需要验证的推理数量会减少,最终可能随机抽选 1% 的推理进行验证。这种动态方法使我们能够保持整体验证百分比较低,同时有效捕获那些试图作弊的参与者。

参与者在每个纪元结束时,根据他们在网络中的权重按比例获得报酬。任务也按权重分配,因此报酬预计会与权重和完成的工作量成比例。这意味着我们不需要立即抓住并惩罚欺诈者,在发放报酬前,在本纪元内抓住他们就足够了。

经济激励驱动这种权衡的程度不亚于技术参数。通过让作弊的成本高昂,而诚实参与有利可图,我们可以创建一个理性的选择是诚实参与的系统。

优化空间

经过数月的构建和测试,我们已经建立了一个系统,它结合了区块链在记录和安全性方面的优势,同时在单次推理性能上接近中心化服务商。安全与性能之间的根本矛盾是真实存在的,没有完美的解决方案,只有不同的权衡。

我们相信,随着网络的扩展,它在保持完全去中心化社区控制的同时,有真正的机会与中心化服务商竞争。随着它的发展,还有很大的优化空间。如果你有兴趣了解这个过程,请访问我们的 GitHub 和文档,加入我们的 Discord 社区参与讨论,并亲自加入这个网络。

关于 Gonka.ai

Gonka 是一个旨在提供高效 AI 算力的去中心化网络,其设计目标是最大限度地利用全球 GPU 算力,完成有意义的 AI 工作负载。通过消除中心化守门人,Gonka 为开发者和研究人员提供了无需许可的算力资源访问,同时通过其原生代币 GNK 奖励所有参与者。

Gonka 由美国 AI 开发商 Product Science Inc. 孵化。该公司由 Web 2 行业资深人士、前 Snap Inc. 核心产品总监 Libermans 兄妹创立,并于 2023 年成功融资 1800 万美元,投资者包括 OpenAI 投资方 Coatue Management、Solana 投资方 Slow Ventures、K 5、Insight and Benchmark 合伙人等。项目的早期贡献者包括 6 blocks、Hard Yaka、Gcore 和 Bitfury 等 Web 2-Web 3 领域的知名领军企业。

官网 | Github | X | Discord | 白皮书 | 经济模型 | 用户手册