原创 | Odaily星球日报( @OdailyChina )

作者 | 夫如何( @vincent 31515173 )

9 月 4 日开始,以太坊基金会(EF)研究团队在 reddit 论坛进行了第 12 次 AMA,社区成员可以在帖子中留言提问,研究团队成员将进行解答。Odaily星球日报对本次 AMA 中涉及的相关疑问、技术要点进行编译。

以下是原文内容,由Odaily星球日报整理,并在相关话题时进行总结,方便读者快速了解。

关于 ETH 价值累积以及对 EF 的影响

以太坊基金会成员认为 ETH 的价值累积对以太坊的成功至关重要。ETH 作为货币,支持去中心化稳定币并为网络提供经济安全性。Justin Drake 强调,以太坊必须成为互联网的可编程货币,而 ETH 的价值累积将通过总费用和货币溢价实现。此外,ETH 的价值增长将支持以太坊生态系统的安全和经济活动,从而推动以太坊成为全球金融平台。虽然不同研究人员的观点不尽相同,但总体上他们认为 ETH 的价值累积不可或缺。

问题 1 : 2024 年 ETH 资产的价值累积论点是什么?以太坊基金会是否认为 ETH 资产的持续价值累积重要?如果按照路线图的其余部分执行,结果是 Rollups 在以太坊L1上形成多样化的生态系统,L2上有大量 DApps,用户支付的费用不到一美分,但 ETH 资产几乎没有价值累积,以太坊基金会会认为这是以太坊路线图的成功实现吗?

Justin Drake - Ethereum Foundation:

首先,我认为 ETH 就是货币。

其次,ETH 的价值累积对以太坊的成功至关重要。以太坊无法成为价值互联网的结算层,除非 ETH 成为互联网的可编程货币。货币溢价只会累积到一种特殊资产上(可能是数十万亿美元的规模)。这种货币溢价的必要性在于:

-

经济带宽:去中心化稳定币(数万亿美元规模)。

-

经济安全:提供不可质疑的安全性,抵御国家级威胁。

-

经济显著性:吸引主要经济体的注意。

最终,ETH 的价值累积归结为资金流动和货币溢价。重要的是总费用,而不是每笔交易的费用。即使每笔交易费用不到一美分,仍能通过 1000 万笔交易/秒产生数十亿美元的收入。例如, 0.002 美元/交易,约 20 亿美元的日收入。此外,ETH 作为抵押货币的使用比例,如支持 DeFi,也很重要。

以太坊正在构建一个金融平台,允许发行、交易金融资产,并创建衍生品。这些活动很有价值,价值捕获机制不确定,但可能基于费用机制。在 Rollup 路线图中,以太坊主网会是高价值活动的交汇点,L1 扩展是必要的。如果当前机制不是最优的价值累积方式,仍有其他有趣的替代方案,如数据可用性费用或 ETH 作为主要交换媒介和抵押物。

Anders Elowsson - Ethereum Foundation:

当以太坊促进可持续经济活动时,ETH 的价值就会累积。“可持续”意味着能够为参与者带来效用并长期持续。在这种情况下,ETH 作为以太坊生态系统中的无需信任的资产,将累积价值。结算支付通过 ETH 完成,ETH 销毁机制会将价值分配给所有持有者。ETH 的价值累积对以太坊的安全性至关重要,因为以太坊的安全是通过 ETH 质押来保证的。

理想情况下,ETH 作为货币应保持其长期价值。在去中心化经济中,拥有可靠、无需信任的货币具有巨大的价值。因此,ETH 的价值累积使以太坊成为更好的平台。此外,未来的大量投资可能以 ETH 形式持有,这也包括以太坊基金会的资金库。

从长远来看,以太坊促进可持续经济活动与 ETH 的价值累积之间存在直接联系。如果设计以太坊来促进可持续经济活动,ETH 的价值累积也会随之而来。

问题 2 :驱动 ETH 代币的价值对以太坊基金会重要吗?

Justin Drake - Ethereum Foundation:

EF 拥有大约 300 人,分布在数十个团队中。我个人不能代表整个 EF 的观点,甚至不能代表 EF 研究团队(38 人)的观点。

我个人的观点是:ETH 代币对以太坊的成功至关重要。ETH 变得有价值甚至极其有价值,会带来积极的连锁反应:

-

经济带宽:去中心化稳定币的核心是 ETH,这对于 DeFi 和以太坊的崛起至关重要。

-

经济安全性:数万亿美元的质押 ETH 可以抵御全球最强大的力量。

-

经济显著性:一旦 ETH 超越 BTC,以太坊和 ETH 将成为不可阻挡的力量。

关于以太坊基金会资金、核心开发及 DeFi 的探讨

以太坊基金会的成员对资金管理的表述大体相同,Vitalik Buterin 提到基金会每年花费剩余资金的 15% ,以确保长期存在。Justin Drake 预计 EF 仍有约 10 年的运营资金,但这会随 ETH 价格波动。

对于核心开发,Vitalik Buterin 和 Carl Beekhuizen 强调,核心开发者不仅限于 EF 研究人员,很多独立开发者也参与其中。

此外,Vitalik Buterin 认为以太坊开发人员紧缺。

最后,EF 对 DeFi 没有统一看法,但个人研究人员认为 DeFi 是以太坊上的重要用例,特别是在去中心化稳定币和金融活动的流动性提供方面。

问题 1 :以太坊基金会当前的资金用完需要多长时间?当这种情况发生时,以太坊基金会计划做什么?

Vitalik Buterin: 目前的预算策略是每年花掉剩余资金的 15% 。这意味着 EF 会永远存在,但随着时间推移,它在生态系统中的影响力会变小。

Justin Drake: 与 此类 似的财务报告应该很快会发布。EF 每年花费大约 1 亿美元( Aya 的这条推文 )。 EF 的主要以太坊钱包 持有约 6.5 亿美元。EF 也有一个法定缓冲区可以覆盖几年的运营费用(正如 Aya 提到的那样,由于监管原因,ETH 销售暂时暂停,因此直到最近缓冲才得到补充。)。估算下来,EF 有约 10 年的运营资金。这条“跑道”会随着 ETH 价格的波动而变化。

问题 2 :以太坊基金会研究与“核心开发”相同吗?还是“核心开发者”是一个更随意的称谓,指那些为协议做出贡献的人?

Vitalik Buterin :EF 外还有很多核心开发人员,最显著的例子是各个以太坊客户端团队的成员(如 Nethermind、Besu、Nimbus)。还有许多独立研究人员和特定主题的贡献者(例如一些 Optimism 和 Base 的人员为 4844 部署做出了贡献)。

Carl Beekhuizen: EF 研究与核心开发者是不同的。核心开发者是那些出于某种原因为客户端或工具做出贡献的人。他们是一群自发的个体,没有固定的界限。参加 ACD 电话的人通常被视为核心开发者,但这既不是必要的也不是充分的标准。

问题 3 :以太坊基金会对 DeFi 有何看法?是否将 DeFi 视为以太坊上最有价值的用例?为什么 EF 不与 Maker、Aave、Comp 等团队对话?

Dankrad Feist: EF 对此没有统一看法。以太坊研究人员有各自的观点,这是我的看法。我喜欢 DeFi,但它并不能单独解决以太坊的所有问题。金融市场本身不创造价值,但通过提供流动性、保险等服务,它们能为社会创造更多价值。

DeFi 在以太坊上最有价值的贡献是去中心化稳定币。我希望这些稳定币能成为“纯粹的”加密货币交换媒介,但它们有严重的扩展限制,因此现在托管解决方案更受欢迎。尽管如此,我认为拥有去中心化的、无需审查的替代方案非常有价值。

此外,DeFi 目前缺乏“有价值”的资产。我相信一旦 DeFi 发展完善,它将使以太坊成为未来金融活动的中心,但还有很多工作要做。

至于与项目的互动,我与许多 DeFi 项目有过交谈。我日常的工作主要是基础设施建设,因此与 DeFi 项目接触较少,但我们确实有互动。

julianma: 我个人认为 DeFi 是以太坊上一个非常有价值的用例,也是一个迷人的应用领域。我过去一年一直在研究 DeFi 相关主题,例如 应用层 MEV 最小化 。我们与 DeFi 团队定期互动。例如,ETHconomics 组织了关于自动做市商的会议,邀请了 DeFi 团队的优秀演讲者。

问题 4 :以太坊的发展是否面临人手不足?

Vitalik Buterin : 在p2p网络领域,人员明显不足,并且这个问题很少被讨论。

EF Research : 核心开发工作确实需要更多的人员,尤其是像分叉选择这样的重要领域。这些领域急需更多的关注和贡献者。

关于以太坊主网未来发展

在讨论关于以太坊的未来发展中,以太坊核心团队成员探讨了几个关键问题。首先,针对以太坊 Layer 1 的扩展问题,Vitalik Buterin 提到,短期内将通过实施 EIP-4444 (历史数据到期)来减少全节点的存储负担,以及通过 Verkle 树和 ZK-SNARKing EVM 来提升性能。Justin Drake 提到,长期计划包括通过 SNARK 技术实现几乎无限制的 L1 EVM 扩展,并提出了增强 EVM 执行能力的想法,如引入 EVM-MAX 和 SIMD 扩展。Dankrad Feist 补充说,扩展 Layer 1 的执行能力是目标之一,但 Rollups 也会继续作为主要扩展方式。

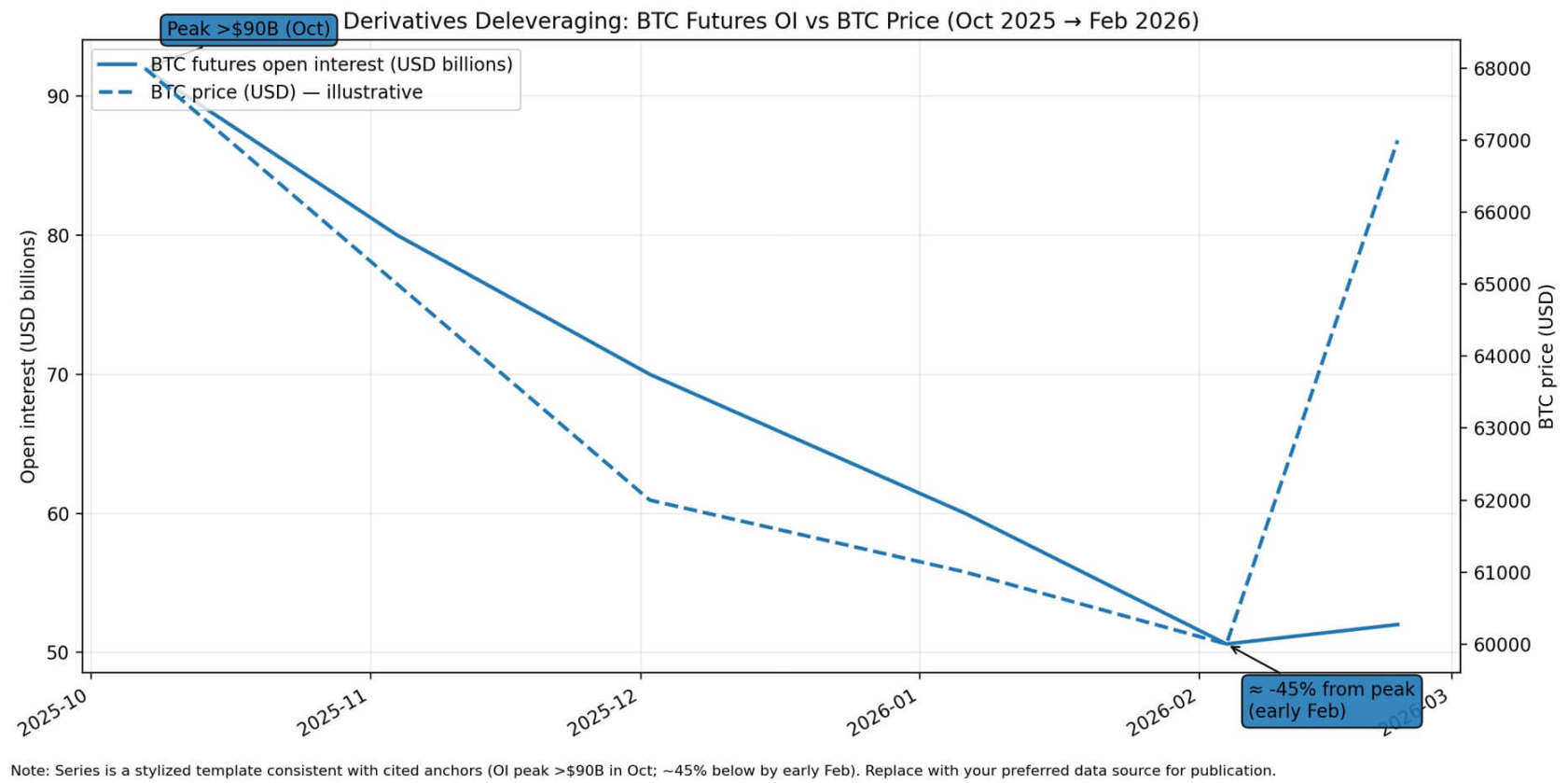

关于以太坊数据可用性市场和 Blobs 费用定价机制,Dankrad Feist 讨论了如何在 Blobs 无法达到目标的情况下调整价格,并建议暂时不要人为提高价格,以免影响 Rollups 的发展。Justin Drake 则认为,Blobs 需求的增长需要时间,并指出一些 Rollup 项目已经找到更好的使用 Blobs 的方法。Davide Crapis 也提到,如果 Blobs 的需求低于预期,应该考虑提高最低费用或加快更新速度来改善机制。

最后,Vitalik Buterin 讨论了如何减少对中心化基础设施的依赖,建议推动轻量级客户端成为消费者钱包的标准配置,并扩展轻客户端的安全保证到 Layer 2 。对于比特币如果实现 OP_Cat 并发展强大的 Layer 2 生态系统会不会影响以太坊的地位,Vitalik Buterin 认为,以太坊仍有独特的价值,如更大的 Rollup DA 空间、更好的权益证明机制以及更高效的社交层、社区和文化。

问题 1 :Layer 2 解决方案逐渐成熟,是否还有计划进一步扩展以太坊的 Layer 1 ?如果有,正在考虑哪些方法?

Vitalik Buterin: 以太坊 Layer 1 的扩展计划包括两种主要策略:

减少全节点负载:

-

实施 EIP-4444 (历史数据到期):这项提案旨在减少全节点的存储负担,通过设定数据保留时间,减少旧数据的存储。

-

Verkle 树 或基于哈希的二叉树:这些数据结构旨在提高数据存储的效率和查询速度,从而减轻全节点的负担。

-

ZK-SNARKing EVM:最终目标是使用零知识简洁非交互式证明(ZK-SNARKs)来验证 EVM 执行,从而降低验证的计算负担。这些改进将为短期内增加 Gas 限制铺平道路。EIP-4444 是最具现实性的短期解决方案,因为它不需要共识层的变更,只需要客户端代码方面的调整。

提升客户端执行能力:

-

改进执行、虚拟机和预编译:提高 EVM 的执行效率,优化虚拟机和预编译的性能。

-

优化状态读/写:解决状态读取和写入过程中的低效率问题。

-

增强数据带宽:提高网络数据传输的带宽,以支持更多交易和智能合约操作。

-

这些方面存在已知的低效问题,改进将有助于进一步提高 Gas 限制。

另一个考虑是向 EVM 添加功能以加速特定计算。一个建议是结合 EVM-MAX 和 SIMD (单指令多数据),提供类似 numpy 的扩展,使得 EVM 能更快地进行大量加密处理。这将使依赖密码学的应用程序更为经济,特别是对隐私协议有重要意义,并且可能减少 Layer 2 提交到链上的成本,从而缩短存款和取款时间。

Justin Drake: 长期计划是通过 SNARK 技术实现几乎无限制的 L1 EVM 扩展。通过实时 L1 EVM SNARKing,验证者可以验证廉价的 SNARK,而无需重新执行 EVM 交易。这将使我们能够在不增加验证者负担的情况下,将 Gas 限制提高多个数量级。所有繁重的 EVM 执行将由专门的节点(如搜索者、构建者、探索者)完成,用户和共识参与者将能够更轻松地运行其节点,甚至可以在手机或手表上运行。

除了通过大幅提高 L1 EVM gas 限制带来的垂直扩展效益外,还可以通过 EVM 内的 EVM 预编译模块实现任意水平扩展。这种预编译模块将允许开发者以编程方式启动新的 L1 EVM 实例,解锁超强版的执行分片,其中分片的数量不再受限于 64 或 1024 个,而是无限的,且每个分片都是可编程的 Rollup(具有可编程的治理、排序、Gas),称为“原生 Rollup”。

一些注意事项:

-

calldata:SNARK 对 calldata 没有帮助,我们可能需要为 calldata 设置一个单独的 EVM Gas 限制。

-

状态增长:如果要限制状态增长,还需为增长状态的操作码设置一个单独的 EVM Gas 限制。处理状态相对便宜,可能不需要限制。

-

物理极限:即使完全取消 Gas 限制,L1 EVM 执行仍面临物理上的垂直扩展限制。好消息是,像 MegaETH 这样的项目声称可以将 EVM 推动到每秒 10 万笔交易,表明 L1 EVM 可能还有几个数量级的增长空间。EVM 性能优化项目,如 Reth 和 Monad,最终将对 L1 产生积极影响。

-

多样性:为了确保验证者能够安全地依赖 SNARK 而不是重新执行,我们需要 zkEVM 客户端的多样性,以对冲 SNARK 错误。目前 zkVM 供应商和执行客户端的多样性大致相同。

-

形式验证:另一种减少 SNARK 错误的长期策略是形式验证。Alex Hicks 和他的团队专注于加速 zkEVM 的形式验证,并拥有 2000 万美元的预算用于拨款和竞赛。如果你是形式验证专家,可以联系他们。

-

实时证明:SNARK 证明的速度必须足够快(大约一个时隙内),以便对验证者有用。SNARK 证明的速度可能会因 SNARK ASIC 的出现而显著提高。延迟一个区块来检查 EVM 后状态根也是一种简单的 EVM 性能优化,有助于 SNARK 化。

Dankrad Feist: 在 Rollup 中心路线图的构建过程中,扩展 Layer 1 的执行能力应当是一个目标,但两者并不一定冲突。数据可用性几乎可以无限扩展,最终的限制在于对以太坊的兴趣,即有多少人愿意认真运行全节点,并记录所有数据。执行能力将始终受到一定限制,最终的瓶颈是单线程限制。通过 zkEVM 和并行化技术,我们可以将 L1 的扩展能力提高 10 至 1000 倍。Rollups 将提供剩余的扩展能力,以满足“世界规模”的需求。

问题 2 :关于以太坊数据可用性市场与 Blobs 费用定价机制,如何应对 blobs 无法达到目标的情况?

Dankrad Feist: 以太坊正在为 Rollups 创建一个新的数据可用性市场。许多替代解决方案(如 Celestia、Eigenlayer、Avail 等)希望从以太坊中抢夺市场份额。由于这些方案在安全性上无法与以太坊竞争,它们可能会在价格上施加压力。因此,我们不应立即人为地提高价格,以免将我们最重要的资产(安全的 Rollup)推离以太坊。

在每个区块提供 3 个 blobs 的情况下,这部分收入对以太坊的协议收入影响较小。我们应专注于尽可能多地扩展此功能,然后再考虑如何从中捕获费用。Blobs 的费用并非以太坊最佳的价值捕获机制。数据可用性市场过于波动,因此它永远不会是一个理想的价值提取方式。以太坊 L1 作为生态系统中的自然金融交汇点,将拥有最高价值的交易,这是 Ether 最好的价值增值机制。

Justin Drake: blobs 不会未能达到目标。我们只需要耐心等待,需求的诱导需要时间才能发挥作用。此外,rollup 项目(如 Base、Scroll 和 Taiko)最近找到更好地利用 blobs 的方法,这也延长了 blob 价格发现的时间表。

Davide Crapis: 如果 blobs 的需求远低于目标,价格保持低水平是合理的。然而,这种情况影响了拥堵情况下的价格发现。我们应使机制更有效,例如通过提高最低费用或加快更新速度等措施来改善。 相关资料 和 近期提案 进行参考。

问题 3 :尽管核心开发人员/EF 研究人员坚持将完整节点要求限制在消费类硬件上,但 99% 的以太坊用户并未运行完整节点,如何减少对中心化基础设施的依赖?

Vitalik Buterin: 我们需要推动轻量级客户端成为消费者钱包的标准配置。Helios 正在不断改进,并且即将为此做好准备。另一个关键部分是将轻客户端的安全保证扩展到 Layer 2 。这在 L2 上实际上比 L1 更为实用和标准化,因为 L2 已经将 L1 状态作为不断更新的信任根。

问题:如果比特币实现了 OP_Cat 并开发了一个强大的 Layer 2 生态系统,那么以太坊还能提供什么独特的价值?

Vitalik Buterin:

-

由于更大的 Rollup DA 空间,第 2 层的安全性有更多选择(比特币每秒只有 4 MB / 600 s = 6667 字节,并且假设所有链上数据都用于 DA;比较 32 kB/秒 EIP-4844 状态现状和 1.3 MB/秒的长期目标);

-

权益证明,逐月证明其保持去中心化的能力,并为 51% 的回收率提供了更多选择;

-

展示了高效的社交层,例如。 审查恐慌 、 客户中心化恐慌 、权益池市场份额中心化恐慌以及许多其他问题,都已通过协调的生态系统范围内的行动得到了解决;

-

社区、文化、价值观等。

关于以太坊基金会的目前研究领域

以太坊基金会正在积极研究多个领域的技术进展。关于零知识证明(ZK),George Kadianakis 介绍了他们在使用 STARKs 和 SNARKs 上的研究,如递归签名聚合和实现后量子安全。Justin Drake 则提到,SNARKs 的引入使得证明成本显著降低,并强调了 zkEVM 的形式化验证工作。

对于可验证延迟函数(VDF),Antonio Sanso 表示,虽然目前尚未在以太坊中实施,团队正研究其潜在应用,但需要进一步改进和评估。

关于最大可提取价值(MEV),Barnabé Monnot 和 s0isp0k e 讨论了 ePBS、Execution Tickets 和 Inclusion Lists 等方案的研究进展,以减少 MEV 的影响并提升网络抗审查能力。

Vitalik Buterin 和 Justin Drake 认为,未来可能会使用二叉哈希树而非 Verkle 树,以适应技术升级。

此外,形式验证和可验证计算被视为确保代码正确性和促进不同程序间互操作性的关键技术。

关于以太坊对 ZK 的研究进展

问题 1 : 以太坊基金会(EF)目前正在从事哪些零知识 (ZK) 研究领域,无论是理论还是实践?在哪里可以找到 EF 当前/过去进行的 ZK 研究?

George Kadianakis:以太坊基金会目前在多个阶段研究不同的零知识 (ZK) 项目,以下是一些与 L1 相关的研究项目例子:

-

使用 STARKs 验证的哈希二叉树以实现无状态性

-

使用递归 SNARKs 进行大规模递归签名聚合

-

通过 ZK 改进网络层的鲁棒性,使用匿名凭证

-

使用 STARKs 作为实现后量子可聚合签名的方法(替代 BLS)

-

使用 ZK 提供单秘密领导者选举设计中的隐私

-

使用 ZK 和 zkEVMs 进行 L1 执行(长期目标)

Justin Drake: 我对将 SNARK 引入 L1 EVM 感到非常兴奋。在过去几个月里,我们取得了巨大的进展。根据 Uma(来自 Succinct)的最新数据,目前证明所有 L1 EVM 区块的成本大约为每年 100 万美元,未来的优化将进一步降低这一成本。我预计明年这个时候,所有 L1 EVM 区块的证明成本可能仅为每年 10 万美元,这要归功于 SNARK ASIC 和堆栈各个层次的优化。以太坊基金会还正在加速 zkEVM 的形式化验证,这是由 Alex Hicks 领导的一个项目,预算为 2000 万美元。

对于信标链,我们最近的基准测试加速了基于哈希的签名与 SNARKs 聚合的时间表。这是实现信标链后量子安全的关键。

关于以太坊对 VDF 的研究

问题 1 :EF 目前好像正在积极研究 VDF,能否提供一些相关内容介绍如何使用它们的信息?比如使用哪些 VDF?你们对当前的 VDF 有什么改进吗?

Antonio Sanso: 以太坊基金会的密码学研究团队在以太坊研究中发布了最新声明,强调了在将可验证延迟函数(VDF)集成到以太坊之前,需要更深入的理解。目前,团队并不建议在以太坊中使用 VDF,并指出需要进一步的研究和显著的改进来重新评估这一立场。更多详细信息可在以太坊研究网站上找到。

在以太坊研究最近发布的一份声明中,密码学研究团队强调,在将可验证延迟函数(VDF)集成到以太坊之前,需要更深入地了解它们。该团队目前不建议在以太坊中使用 VDF,并指出正在进行的研究和重大改进对于未来可能修正这一立场至关重要。有关更多详细信息,请参阅 此处的 完整声明。

Mary Maller 在 Devconnect 会议上讨论了 VDF,可以在这里查看她的演讲。另外,我在 2024 年的 IC 3 冬季研讨会上也讨论了相关话题,活动详情可见此处。

此外,Mary Maller 在 Devconnect 的演讲中讨论了 VDF,可以 在此处 查看。我还在 2024 年 IC 3 冬季静修会上介绍了相关主题,活动详情请点击 此处 。

Justin Drake: VDF 有两个方面:

-

将生产级 VDF 构建为加密原语。

-

在应用程序中使用该原语。

在应用程序方面,VDF 的激励用例包括加强 RANDAO,以获得领导者选举的无偏随机性。IMO,VDF 是 L1 随机性的最终目标,并且在 Vitalik 的路线图中仍然是一个“挥霍”项目。到目前为止,没有证据表明 RANDAO 正在被滥用,因此 VDF 研发的优先级已被降低。其他 L1 项目(例如包含列表、权益上限、SNARKifying L1)更为重要。

VDF 的另一个重要用例是彩票。建立一个“世界彩票”是一个有吸引力的机会,它是可证明公平的、全球范围的、无佣金的。如果你想构建这个,请私信我:) 最近出现的 VDF 的另一个有趣的应用是促进在多重提议的背景下同时发布块。

对于 VDF 基元本身,事实证明这比我预期的要困难得多,但隧道尽头有曙光。我们现在拥有 MinRoot VDF ASIC,我相信它可以用于彩票生产,尽管理论上的 MinRoot 分析没有对 256 位 MinRoot 进行实际攻击。我们现在需要一个团队来完成集成工作,以在链上验证 MinRoot SNARK 证明(例如 Nova 或 STARK 证明)。这对于 BN 254 MinRoot 来说很容易,但 Pasta 曲线需要包装器 SNARKs。

关于 MEV

问题:MEV 研究目前的方向是什么?我对这么多提案感到有点困惑,例如 ePBS、Execution tickets、Inclusion lists、BRAID、PEPC、MEV-sharing 等等。

EF Research: 关于 MEV 研究中的一些术语可能确实让人困惑,我会尽量简洁地定义你提到的几个概念:

-

ePBS(enshrined Proposer-Builder Separation):其主要目标是摆脱对第三方(例如中继器)的信任,直接在建设者和提议者之间进行交互。目前有一个相关的 EIP 正在讨论: EIP-7732 ,并且在这方面有很多工作正在进行。

-

Execution Tickets (ETs) 和 Execution Auctions (EAs):这些都属于更广泛的“Attester-Proposer Separation (APS)”概念,其目标是进一步分离共识角色(如提议和验证)以防止 MEV 导致的负面影响,例如时间博弈(timing games),这些可能会破坏共识。

-

Inclusion Lists (ILs):这是为了提升网络的抗审查能力,让以太坊的去中心化验证者集合更好地强制交易被包含在区块中,并限制建设者的权力。在这方面已经取得了很大的进展,最近的提案是 FOCIL( Fork-choice Enforced Inclusion Lists ),这个提案很有潜力。

-

BRAID:这是 Max Resnick 提出的一个新概念,旨在通过让多个提议者同时运行多个平行链来提升抗审查能力并解决 MEV 问题。我最近写了一篇笔记比较了 FOCIL 和 BRAID,可以在 这里 找到。

-

PEPC(Protocol-Enforced Proposer Commitments):这个提案的目的是为验证者提供一个协议工具,让他们可以对生成的区块做出绑定承诺。Barnabé 的 PEPC-FAQ 提供了更详细的解释, 链接在此 。

-

MEV-share:这是由 Flashbots 提供的一个解决方案,它允许用户将交易发送到 Flashbots 的 RPC,而不是公共内存池,这样可以避免 MEV 抽取,还可能从生成的 MEV 中获得回报。不过需要注意的是,这个方案是中心化的,用户需要信任 Flashbots,而且它是在协议外进行的。

Barnabé Monnot: 关于 MEV 研究,当前有两个主要的方向:

-

具体的协议升级提案:例如 ePBS 和 FOCIL(基于委员会的 Inclusion Lists 或多提议者形式)。这些提案都是目前正在讨论和推动的具体方案。

-

更广泛的研究方向:例如 Attester-Proposer Separation (APS),它涵盖了 Execution Tickets 和 Auctions 的概念,以及 BRAID。我个人希望具体的工作可以为这些更具前瞻性的研究提供支持。

此外,我们最近为 ePBS 设立了一个追踪系统,并且我们正在扩展该系统以添加更多的材料。你可以查看相关笔记以了解更多内容。

关于 APS+ FOCIL + ePBS 与 BRAID

问题 1 :APS+ FOCIL + ePBS 或 BRAID 如果能够有效应用,你觉得对以太坊的帮助怎么样?

s 0 isp 0 ke EF Research: 我最近写了一篇比较 FOCIL 和 BRAID 的笔记 :

-

FOCIL 可以被认为是一个小工具,或者是现有以太坊协议的一个附加组件。它专注于利用多个验证器来提高网络的抗审查性能,但对当前区块市场结构的干扰最小化。

-

BRAID 的范围要广泛得多,因为它不仅旨在提高 CR,而且还通过试图阻止任何一个提议者拥有相对于其他提议者的特权角色或特殊优势来“解决”MEV。这涉及从头开始构建一个协议,采用新的共识机制,并对执行层(例如排序规则)和市场结构进行重大更改。

对我来说,你的问题很难准确回答,因为“如果它有效”部分,但我认为这两种方法都有优点,而且好的一点是它们并不相互排斥,并且正在并行工作。

Justin Drake: 我很高兴 BRAID 正在接受调查,但从今天开始,我完全站在 FOCIL + APS 阵营。

我认为 BRAID 的根本问题是它引入了可能高度集中的“垂直”多块游戏。这相当于可以使用连续老虎机玩的多老虎机游戏,但跨越“空间维度”而不是时间维度。

假设我们正在使用 n= 4 个并发提议者进行 BRAID。如果一个大的运营商控制了 k>1 个提议者,那么提议者的公平性就会崩溃:

-

k= 2 :有一个所谓的“有风险的最后查看”攻击向量。基本思想是提议者之一采取保守行动,并按时提出一个胖块以收取纳入费。另一个提议者在证明边界处提出了一个薄块,其中包含来自计时游戏的一堆“最后查看”MEV。

-

k= 4 :这就是事情真正误入歧途的地方。一个实体异常地赢得了该插槽的完全控制权,并且可以最大限度地提取所有 MEV。这可能是高度中心化的,因为大型运营商(例如 Coinbase 或 Kiln)偶尔会“赢得 MEV 大奖”,而小型运营商只能“获得 MEV 灰尘”。

-

k= 3 :这里的事情也变得很危险。例如,大型运营商有动机拒绝他们无法控制的第四个提议者,本质上又回到了 k= 4 的情况。大型运营商也有与第四个提议者勾结的动机,同样是因为 MEV 大奖。

julianma EF Research: Mechan-stein (APS + FOCIL + ePBS) 和 BRAID 都是非常令人兴奋的方向。然而, FOCIL + ePBS 与 BRAID 处于非常不同的研发阶段。前者很好理解:有 FOCIL 的详细描述和 ePBS 的 EIP。后者是一个令人兴奋的新想法,仍需要大量研究。

我认为 Mechan-stein 和 BRAID 不必被视为相互竞争,而是对区块共同创造的探索。

关于 Verkle 树与状态树

问题 1 :人们普遍认为,Pectra 之后的下一个 HF 将专门用于 Verkle 树。随着 ZK-proof 技术的快速发展,让当前的 MPT snark 变得友好有什么优势吗?

Vitalik Buterin: 我个人目前赞成将后 Pectra 分叉转向各种与状态树无关的事物,特别是包含列表,也许是 Orbit (只是洗牌机制,没有 SSF 部分),以允许验证者(少得多)超过 32 ETH 参与,也许是一些 EVM 的改进或简化。这将为我们提供喘息的空间,让我们可以直接跳到二叉哈希树,了解之后分叉中的状态。

我们看到 Starkware 证明了 CPU 上每秒 > 600 k Poseidon 哈希值,但 Poseidon 由于其新颖性而备受争议。也就是说,有一些更新的方法(例如 GKR)即使对于更“传统”的哈希值(例如可能是 BLAKE 3)也可以提供足够高的性能。因此,无论是对 Poseidon 进行更多的安全分析,还是更成熟的 GKR,或者第三种选择(例如基于格的哈希)都可以帮助我们实现这一目标。

Justin Drake: 我同意这种观点,并且我相信其他几个人也同意 : ) 我的倾向是重新调整无状态工作的用途,使用二元 Merkle 树而不是 Verkle 树。许多繁重的工作都在状态树转换点进行,Verkle 转换工作可以重用于二元 Merkle 树。

SNARK 证明变得异常快。 7 月,笔记本电脑 CPU 证明 每秒可处理 120 万个 Posseidon 2 哈希值 ,这打开了“奥弗顿窗口”。该基准测试可能已经过时了,尤其是当 GPU 加速加入其中时。 SBC 的 Eli Ben-Sasson 提供的初步数据表明,GPU 加速将提供 5 倍的速度提升,甚至可以使用 SHA 256 二叉树。

IMO 出于以下几个原因,使用 GPU 加速实现无状态是完全可以的。首先,无国籍性是在诚实的少数派假设下运作的,这一假设有意义,即我们只需要世界各地的少数实体为无国籍性计算 SNARK,而这些实体不需要成为共识参与者。其次,随着时间的推移,随着 CPU SNARK 证明继续其看似不可阻挡的指数加速,对 GPU 的需求自然会消失。

关于形式验证和可验证计算在以太坊的应用

问题 1 :你认为以太坊生态系统中形式验证和可验证计算的未来是什么样的,特别是它对互操作性的潜在影响以及将非 Solidity 开发人员引入生态系统?

Justin Drake: 形式验证和可验证计算与一个共同目标紧密相关:我们希望信任网络中每个人都在运行的代码。这是我们想要使用区块链的核心原因。可验证计算使我们能够获得程序执行的加密证明,并且通过 zkVM,我们可以对任何可以编译为底层 ISA(例如 RISC-V)的程序执行此操作。这就是形式验证发挥作用的地方。首先,zkVM 很复杂,因此您需要确保其实现中不存在任何问题。其次,如果您正在运行一个特别重要的程序——假设您正在运行 EVM,那么您有一个 zkEVM——您还需要确保该 EVM 是 EVM 的正确实现。我还想强调,这里的形式验证不仅仅是检查我们已经拥有的内容的正确性,它还允许我们进一步优化事物并从代码中获得更好的性能,否则这些代码可能很难审核,同时仍然拥有正确的保证。

关于互操作性和将非 Solidity 开发人员引入生态系统,我认为两者都有帮助。可验证计算消除了重新执行计算的需要,因此如果您有一个 snark 证明程序在某个 VM 上执行,您可以在另一个 VM(可能具有不同的 ISA 或 w/e)上验证这一点。这有助于互操作性,并为开发人员提供更大的灵活性。形式验证并没有直接的帮助,但我认为它会带来一些有趣的事情。如果我们达到了程序验证成本低廉的地步;例如,通过自动化,无论是使用求解器还是人工智能,都可以更轻松地生成可以检查正确性和安全部署的代码,将代码从任何语言翻译为可靠的代码,并保证保留程序的语义,或者提示 LLM 生成一份合同,并附上证明您的合同实现了所需规范的证据。

以太坊保持可信中立性的措施

以太坊基金会正在采取多种措施以确保以太坊网络的可信中立性。为了增强网络的审查阻力,基金会正在实施包含列表(IL)机制,这允许去中心化的验证者集强制将交易包含在区块中,减少对少数复杂实体的依赖,例如那些可能会审查与受制裁地址交易的实体。具体的提案包括分叉选择强制包含列表(FOCIL),旨在进一步提升这一机制的效果。

研究人员还在探索其他方法,如彩虹质押提案,它建议协议引入多种类别的服务提供商,以确保去中心化验证者集的多样化,从而增强中立性。这些措施的目的都是为了确保以太坊在面对政府压力时能够维持其中立性和公正性。

问题 1: 由于政府无法向验证者施压以审查特定交易(例如涉及受制裁地址或智能合约的交易),Ethereum Foundation(EF)正在采取哪些措施来确保以太坊保持可信的中立性?

Justin Drake: 以太坊基金会正在通过迭代“包含列表”(IL)设计来增强网络的审查阻力(CR)。IL 允许去中心化的验证器集强制将交易包含在构建者的区块中,从而减少对少数复杂实体的依赖,这些实体可能会决定哪些交易被包含在以太坊区块中(例如,审查与受制裁地址交互的交易)。我们最新的提案是分叉选择强制包含列表(FOCIL),可以参见 FOCIL 提案 。

Barnabé Monnot: 以太坊基金会的研究人员正在探索多种方法来确保可信的中立性。具体来说,包含列表机制允许更多的参与者对区块构建做出贡献,从而反映出多个人的偏好。只要验证者集能够展现出多样化的偏好(即去中心化的验证者集),这些方法就能够有效地确保可信的中立性。

此外,质押经济学也是确保可信中立性的关键因素之一。特别是彩虹质押提案,建议协议可以包括多种类别的服务提供商,而不期望所有利益相关者提供所有服务。这种分工可能允许协议拥有一组专注于显示其他人可能遗漏的交易的服务提供商。详细信息可以参见 彩虹质押提案 。

关于以太坊过度发行问题及其解决方案

在讨论以太坊过度发行问题时,Justin Drake 表示,目前,解决以太坊过度发行的提案包括调整发行奖励曲线、设定经济封顶、有限发行和最小化发行量等。这些提案的推进主要受限于社会协调,需要社区达成共识,并推动相关的以太坊改进提案(EIP)。

Anders Elowsson 则给出更详细的解答,表述所遇到的问题,PID 控制器作为一种调整质押奖励的工具,能动态调整收益率以平衡供给曲线与奖励曲线的交点。然而,PID 控制器也有缺点,如可能导致过低的收益或过高的发行量,进而增加用户成本。为解决这些问题,研究者正在探索 MEV 销毁等解决方案。

对于质押比率,虽然设计一种智能的发行曲线以应对高质押率(如 50% )是可行的,但实际进展依赖于社区的支持和协调。质押参与率的增长是渐进的,预计未来几年内可能逐步上升。通过适度减少发行量,可以缓解这种增长的速度。总的来说,未来的进展将取决于社区对提案的接受程度及其实施的速度。

问题:我们离解决以太坊过度发行的提案有多近?我们是否可以使用类似 Rai 的 PID 控制器来针对质押比率,而不是固定发行曲线?在质押比率达到像 50% 这样高度不理想的水平之前,我们还剩下多少时间?

Justin Drake: 设计一个智能的发行曲线,围绕一个软上限(如四分之一、三分之一或二分之一的 ETH 被质押)逐渐归零是显而易见的选择。主要瓶颈在于社会协调。需要一个聪明且有动力的人推动 EIP(以太坊改进提案)直到上线。我预计社区会对此表示支持。

Anders Elowsson:

1. 过度发行问题

目前,有多个提案正在讨论如何调整以太坊的发行策略。这些提案包括调整发行奖励曲线、设定经济封顶(目标)、有限发行以及最小化发行量(MVI)等。相关研究文章和常见问题解答也探讨了这些选项。

目前,我们需要在以太坊社区内推动减少发行的运动,并展开关于减少发行程度的深入讨论。由于发行政策的调整非常敏感,形成共识将有助于推进相关提案。

2. PID 控制器的应用

PID 控制器可以作为调整质押奖励的一种工具,通过设定目标质押数量或比例来调节奖励曲线。长远来看,PID 控制器的主要优点是能够动态调整收益率以平衡供给曲线与奖励曲线的交点。然而,这种方法也存在缺点:

-

过低的收益:如果收益设置过低,个人质押者可能会因固定成本较高而退出,这可能导致发行收益为负值,即每个纪元从质押者那里扣除费用。

-

过高的发行量:设定的目标过高可能导致发放过多代币,增加用户成本。

PID 控制器可能会尝试将发行收益率设为负数,但这会带来额外问题,如共识破裂和奖励变异性增加。解决这些问题的最佳方法是探索 MEV 销毁或其他防止提案者提取 MEV 的解决方案,但这些解决方案目前仍在研究阶段。

3. 发行量过高的风险

固定的奖励曲线无法限制发行量的高低。如果目标设置过高,可能会导致发行过多代币,增加用户成本。以太坊的奖励曲线需要在长期内优化所有已知的收益和股权参与的权衡,以反映其派生效用。

4. “泄气攻击”的挑战

质押者可能会遇到“泄气攻击”,攻击者通过剥夺诚实参与者的奖励来获利。为了应对这种攻击,协议可以设定固定目标参与水平,增加留下股份的动机。然而,这些措施也可能导致次优的奖励曲线。

5. 动态方法的潜力

尽管 PID 控制器有其缺陷,但结合动态方法可以提高其有效性。这种方法允许奖励曲线在较长时间尺度上进行调整,从而在一定程度上解决了 PID 控制器的不足之处。

6. 50% 质押上限的讨论

如果质押参与率达到 50% ,意味着超过一半的潜在 ETH 持有者认为质押的风险/回报是值得的。质押参与率的增长是渐进的,适度减少发行量可以帮助控制这种增长。虽然质押参与度可能在未来几年逐渐上升,但预计增长速度会放缓。

总的来说,虽然存在多种调整以太坊发行量和质押奖励的方法,但每种方法都有其优缺点。未来的进展将依赖于社区的共识和对各种提案的深入讨论。

问题 2 :您认为 ETH 应该长期处于净通缩状态吗?在 EIP 4844 之前,用户支付高额费用,而 ETH 处于通缩状态。4844 之后,我们的用户支付较低的费用,而 ETH 正在通货膨胀。我们怎样才能真正实现这两个目标:(1)ETH 处于通缩状态;(2)普通用户的费用低。

Justin Drake: 长期实现 ETH 的净通缩状态需要解决几个关键点。首先,通缩和低费用的目标是通过扩展规模来实现的,这有助于可持续的经济活动。理想情况下,这应包括数以百万计的用户支付低廉的交易费用,并由以太坊网络保护这些交易,从而增加总费用并实现可持续的经济增长。Barnabé 在三年前的 AMA 中从用户角度详细解释了这一点。

在讨论 EIP 4844 之前和之后的情况时,需要考虑以下几点:

-

扩展与费用:Layer 2 解决方案在以太坊上开发,之前因高昂费用而推迟部署,但路线图的存在预示着未来费用会降低。如果没有这些扩展承诺,Layer 2 可能不会发展到今天的水平。此外,当前的 Gas 价格不仅反映了过去的情况,也反映了未来扩展的承诺。这表明,放弃扩展可能不会使以太坊出现净通缩,因为交易需求也受到未来扩展计划的驱动。

-

长期通缩要求:实现永久的净通缩不仅需要减少发行量或增加费用消耗,还涉及长期的质押均衡。这种均衡是根据质押金额(存款规模 D)而不是质押比例(存款比率 d)来调整的,并且受到循环供应平衡的影响。为了实现永久通缩,需要在奖励曲线方程中将 D 替换为 d,并在流通供应量开始按共识进行跟踪时,通过在交易中纳入流通供应量来进行标准化层。

总之,ETH 的长期净通缩状态需要在调整发行政策和管理交易费用之间找到平衡,以确保可持续的经济活动和低费用结构。

以太坊基金会对 L2 的相关探讨

讨论主要围绕以下几个方面:Base L2 的 Gas 限制和 Blob 需求,L2 的用户体验改进,L2 与以太坊 L1 的关系,基于测序的最新进展,以及去中心化排序器的动机。

关于 Base L2,Vitalik Buterin 解释了达到每秒 1 Giga Gas 目标所需的 Blob 计数,并讨论了实现目标的不同途径,包括增加数据带宽、优化数据压缩和转换架构。Francesco 进一步探讨了估算所需 Blob 数量以及如何根据当前使用模式预测 Blob 需求。

在改进 L2 用户体验方面,Carl Beekhuizen 提到,他们正在推动 L2 标准化,以便在 L2 之间实现功能兼容,并解决跨 L2 生态系统中的碎片化问题。此外,Vitalik Buterin 和其他人也在推动围绕钱包和桥接的标准化工作。

对于 L2 与以太坊 L1 的关系,Justin Drake 对 Max Resnick 的批评做出了回应,认为 L2 有激励去中心化排序器以最大化费用,而不是集中化排序器。他解释了 Base 的收入模式以及为什么排序器费用的术语可能具有误导性。

最后,关于基于测序的最新进展,Justin Drake 介绍了多个计划中的基于 Rollup 的组件和预会项目,以及近期的开发进展,包括预配置开发网和测试网。他还提到了即将举行的测序周活动以及对未来工作的展望。Vitalik Buterin 则认为,去中心化排序器虽然重要,但短期和中期应关注更多实际问题,例如劳动力包容渠道和完全去信任化。

问题 1 :Base L2 在提高其 Gas 限制,距离每秒 1 Giga Gas 目标仅剩 1% 。需要多少目标 blob 计数来支持此目标?实现这一目标的时间线如何?如果 Base 购买 100% 的 Blob,所需 Blob 数量是多少?未证实的假设是 Base 可能会转换为 validium 或 volition。

Vitalik Buterin: 现在,平均区块大小为 70 kB,平均区块 Gas 消耗量为 15 Mgas,即每字节 214 Gas。因此, 1 Ggas/秒将需要 4.67 MB/秒的数据带宽,这比我们为完整 DAS 设定的 1.33 MB/秒目标高出几倍。如果我们想到达那里,有三种途径:

-

努力使 DA 带宽甚至高于 16 MB/插槽。这将需要大量的研究和实际工作,尽管这并非不可能。

-

Base 采用理想的数据压缩,应该能够减少约 7 倍的链上数据消耗。这会将 Base 的使用需求减少到约 667 kB/秒,这恰好是以太坊数据容量的一半。

-

Base 可能会转换为 Plasma 架构。

Francesco: 回答这个问题并不容易,因为最终它取决于 L1 上使用的 Gas 与发布的字节的平均比率,这本身取决于 L2 上消耗 Gas 的活动类型,以及实现的压缩比在实践中的效果。尽管如此,我们还是可以通过一些猜测来尝试一下。假设我们只考虑消耗约 60 k Gas 的 ERC-20 传输,并考虑此处讨论的此类传输的压缩。

然后, 1 Ggas/s 对应于约 16 k 传输/秒,在“具有聚合的 ERC-4377 ”场景中对应于约 16 blob/s,或约 195 blob/slot,并且在压缩估计的最佳情况下约 3 blob/s,或约 36 blob/slot。在前一种情况下,这将需要比 128 blob 目标多约 50% 的容量,而这一目标已经成为了一段时间的目标,但在后一种情况下,这只需要大约 1/4 的容量。

也许更有用的看待它的方法是只关注当前的活动。根据此仪表板,在撰写本文时,在 10 Mgas/s 的速度下,Base 在过去 12 小时内消耗了 2435 个 blob,即约 0.05 blob/s。将相同的使用模式预测为 1 Ggas/s,他们将使用约 5 blob/s,或约 60 blob/slot,介于之前的两个估计之间。这直观上是有道理的,因为 Rollup 可能有相当多的更复杂的活动,这可以有更好的 Gas/字节比,但另一方面,我的理解是我们距离最佳压缩还很远(没有 Rollup 有状态压缩)。平均而言,对于这种活动,容量为 128 blob/slot 的 DA 层可以支持大约 2 Ggas/s。从中长期来看,我认为这种情况必然会有所改善,尽管幅度可能不会很大。

问题 2 :如何改进 L2 的用户体验(UX)以及跨 L2 的体验?

Carl Beekhuizen: Ansgar、Yoav 和我一直致力于 L2 标准论坛的工作,以便就跨 L2 存在的功能进行协作。这个想法是,如果特定的 L2 想要发布某个功能(例如,多维 Gas 定价),那么他们可以将其编写为 Rollup 改进提案(RIP),然后他们可以从其他 L2 团队获得有关更改的反馈,这将有助于使其对更广泛的行业更有用,然后其他任何人都可以提供相同的功能并且它应该是兼容的。

通过为标准和讨论提供一个中立的平台,我们希望能够仅以一种方式交付事物,这样 DApps/钱包/用户只需了解一种模式,并且它只需在 L2 生态系统中运行即可。

此外,Vitalik Buterin 和其他人最近推动围绕钱包和桥接建立一些标准,这应该有助于解决这种碎片化的应用程序层方面的问题。

问题 3 :EF 对 Max resnick 对 L2 与以太坊 L1 日益增长的寄生关系的批评有何看法?为什么 L2 没有更快地去中心化?我们如何激励他们更快地行动?

Justin Drake: 我已经看完 Max 最近的《Bankless》一 集了 30 分钟,我相信他搞错了。我已经和他私下讨论过这个问题,所以这篇文章应该不会让人感到惊讶。他多次强调的核心前提是,L2 没有动力去中心化,因为它们会损失测序费用。他还在 Twitter 上分享了这一观点,例如 此处 和 此处 。在播客和 Twitter 上,他特别提到 Coinbase 通过 Base 赚取了 2 亿美元的年费。与直觉相反,L2 被激励分散测序以最大化费用——这与 Max 的主张相反:)

“排序器费用”这个术语确实很不幸,因为它具有误导性。 Base 100% 的收入来自执行拥堵费。基本费用由模仿 L1 的 EIP-1559 风格的 Gas 机制决定(请参阅 此处的 文档)。最大的区别在于,基本费用被发送到 Coinbase 钱包,而不是像 L1 那样被烧毁。

Coinbase 赚这么多钱是因为 Base 上的 Gas 需求大于 Gas 目标。这是一个虚拟机吞吐量问题,拥塞费用基本上与排序无关。如果 Base 使用去中心化排序器,Coinbase 仍将收取这些拥堵费。例如,如果 Base 使用 L1 验证器进行排序并成为“基于 Rollup ”,Coinbase 仍将收取执行拥堵费。拥塞费源自基础 VM 气体目标。排序器只是告知用户有关 L2 拥塞费用的信息——排序器扮演的是表面角色。价值创造源于基础 VM 气体目标和区块空间供需不匹配。

在我看来,术语“排序器费用”的唯一有效用途是 MEV,其中价值捕获确实源自排序,即抢先交易和后台交易的战略定位。 Base 的排序采用先到先得的方式,使用私有内存池,用户将其交易端到端加密发送到 Base 排序器。 Coinbase 没有捕获 MEV——没有排序器费用——而且我不知道今天哪个 L2 捕获了 MEV。Base 捕获 MEV 将以牺牲用户的利益为代价,例如交换者将被夹在中间,或者 DEX LP 将更多地受到不利流动的影响,最终导致交换者的价格更差。 L2 自然不想降低用户的执行质量,因此 MEV 提取不会在 L2 上发生。

故事还在继续。事实证明,排序器费用除了不利于 L2 内的执行质量之外,也不利于跨 L2 可组合性。事实上,要提取 MEV,需要某种专有的测序基础设施,并且排除了两个专有测序仪之间的共享测序。如果没有共享排序,称为“同步可组合性”的可组合性黄金标准就会丢失。请参阅标题为“为什么同步有价值?”的 演讲 。可组合性的侵蚀减少了跨 L2 交易的机会(例如来自 1inch DEX 聚合器),这最终减少了拥堵费用。为了最大化费用,L2 应该最大化拥堵费,这意味着最大化可组合性。

为了最大限度地提高可组合性,我们需要共享排序。作为一个社区,我们如何协调规范的以太坊范围内的共享排序器?两个相互竞争的 L2(例如 Arbitrum 和 Base)只会同意选择一个可信中立的共享定序器。 IMO 只有去中心化和无需许可的排序器才能实现足够可信的中立性。你们中的一些人可能知道,我有一个更强有力的论点:在我看来,唯一可信的以太坊范围内的排序器是以太坊本身,它不会引入新品牌、新代币或新的安全假设。

为什么 L2 没有更快地去中心化?去中心化测序仪很困难并且需要时间。 L2 目前使用集中式排序器作为三个不同事物的训练轮:

-

安全性:集中式排序器可防止攻击者未经许可地利用欺诈证明或 SNARK 错误,即使这些错误存在于主网上。去中心化排序器意味着拥有多重证明、形式验证或其他一些安全训练轮(如 TEE)。

-

MEV :集中式定序器提供快速而肮脏的加密内存池,以防止 MEV 提取。去中心化排序器意味着拥有精美的加密内存池,例如 SUAVE 或其他一些合适的 MEV 管道。

-

preconfs :集中式排序器提供快速的用户体验。去中心化测序仪意味着拥有低延迟共识或使用正在 积极研发的 加密经济预先确认。

更正:Base 是优先费用拍卖,采用先到先得的平局法。这意味着 CEX-DEX 套利 MEV 将作为排序器费用计入 Coinbase。 Uniswap v4 钩子附带更好的 DEX 设计,不会将 MEV 泄漏给定序器(而是回扣给 LP)——例如参见 Sorella 。

问题 4 :基于测序的最新进展是什么?

Justin Drake: 我们现在在主网上有一个基于 Rollup 的组件——Taiko。 这张幻灯片 显示了许多 L2(Gwyneth、IntMax、Keyspace、Puffer、RISE)也计划推出基于 Rollups 的计划。现在还有一个蓬勃发展的预会项目行业,包括 Bolt、Espresso、Interstate、Luban、Monea、Primev、Spire 和 XGA。研发工作正在幕后稳步推进。

我们已在伦敦、柏林、布鲁塞尔进行了 14 次测序通话 以及 3 个现场测序日。 6 月,我们推出了 预配置开发网 , 7 月 推出了测试网 Helder 。 8 月,Bolt 发布了 L1 包含预配置的 alpha 版本 。用于提议者承诺的 Commit-Boost 中立 sidecar 将很快接受安全审核,以便在主网上使用。

接下来是 11 月 4 日至 8 日在 清迈 Edge City 举行的测序周,以及 Devcon 期间 在曼谷举行的第四个测序日 。乐观地讲,我们今年可能会在 Taiko 上获得执行预配置。在补充基础设施方面也取得了扎实的进展,例如实时证明器(基于 TEE 和基于 SNARK 的)和 AggLayer 的跨 L2 安全性。我预计我们的工作成果将在 2025 年开始结出果实,并且我希望人们对基础测序的兴趣将会增强。从长远来看,现在也有减少 L1 时隙时间的动力,这有利于基于排序。

问题 5 :Rollups 是否有动机不分散其测序器以保留测序费用?

Vitalik Buterin: 实际上,我认为去中心化排序器的 Rollup 不一定是重中之重。对我来说,从短期和中期来看,重点关注以下方面是可以的:

-

拥有劳动力包容渠道(这使得 L2 继承了 L1 的审查阻力)

-

进入 第二阶段 (完全去信任,任何安理会只能在出现可证明错误的情况下进行干预,例如,两个应该等效的证明系统不一致,或者一个证明系统接受同一块的两个不同的后状态根)

我要补充的另一件事是,对我来说,费用收集和排序器去中心化是正交的。如果排序器是集中式的,那么你进行排序并收取费用+MEV(但要花精力弄清楚如何获得 MEV)。如果定序器是去中心化的,那么你将通过拍卖定序器插槽获得收入,在均衡状态下,该收入等于费用+MEV 减去计算如何获得 MEV 的成本。情况看起来是对称的。

我看到的主要不对称性可能是社会性的:虽然排序器是中心化的,但更容易逃避收取费用+MEV,而不是把它们交给你的代币持有者(或与你的社区公开同意的任何分配方式),但从经济角度来说,去中心化需要“做正确的事”。但我希望 L2 实际上不会因为这个原因而保持中心化,并且我希望社区(包括像 L2beat 这样的组织)考虑到这一点并警惕这种情况。